Difference between revisions of "Aufgaben:Exercise 4.2: Triangular PDF"

m (Guenter verschob die Seite 4.02 Dreieckförmige WDF nach 4.2 Dreieckförmige WDF) |

|||

| Line 2: | Line 2: | ||

}} | }} | ||

| − | [[File:P_ID2865__Inf_A_4_2.png|right|]] | + | [[File:P_ID2865__Inf_A_4_2.png|right|Zweimal dreieckförmige WDF]] |

| − | Betrachtet werden zwei Wahrscheinlichkeitsdichtefunktionen (kurz WDF) mit dreieckförmigem Verlauf | + | Betrachtet werden zwei Wahrscheinlichkeitsdichtefunktionen (kurz WDF) mit dreieckförmigem Verlauf. |

| − | + | * Die Zufallsgröße $X$ ist auf den Wertebereich von $0$ und $1$ begrenzt, und es gilt für die WDF (obere Skizze): | |

| − | $$f_X(x) = \left\{ \begin{array}{c} 2x \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} 0 \le x \le 1 \\ {\rm sonst} \\ \end{array} | + | :$$f_X(x) = \left\{ \begin{array}{c} 2x \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} 0 \le x \le 1 \\ {\rm sonst} \\ \end{array} |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | * Die Zufallsgröße $Y$ besitzt gemäß der unteren Skizze die folgende WDF: | |

| − | $$f_Y(y) = \left\{ \begin{array}{c} 1 - |y| \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} |y| \le 1 \\ {\rm sonst} \\ \end{array} | + | :$$f_Y(y) = \left\{ \begin{array}{c} 1 - |y| \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} |y| \le 1 \\ {\rm sonst} \\ \end{array} |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | * Der Zusammenhang zwischen den zwei Zufallsgrößen ist durch die Gleichung $X = |Y|$ gegeben. | |

| − | Für beide Zufallsgrößen soll jeweils die [ | + | |

| − | $$h(X) = | + | |

| + | Für beide Zufallsgrößen soll jeweils die [[Informationstheorie/Differentielle_Entropie|differentielle Entropie]] ermittelt werden. Beispielsweise lautet die entsprechende Gleichung für die Zufallsgröße $X$: | ||

| + | :$$h(X) = | ||

\hspace{0.1cm} - \hspace{-0.45cm} \int\limits_{{\rm supp}\hspace{0.03cm}(\hspace{-0.03cm}f_X)} \hspace{-0.35cm} f_X(x) \cdot {\rm log} \hspace{0.1cm} [ f_X(x) ] \hspace{0.1cm}{\rm d}x | \hspace{0.1cm} - \hspace{-0.45cm} \int\limits_{{\rm supp}\hspace{0.03cm}(\hspace{-0.03cm}f_X)} \hspace{-0.35cm} f_X(x) \cdot {\rm log} \hspace{0.1cm} [ f_X(x) ] \hspace{0.1cm}{\rm d}x | ||

\hspace{0.6cm}{\rm mit}\hspace{0.6cm} {\rm supp}(f_X) = \{ x: f_X(x) > 0 \} | \hspace{0.6cm}{\rm mit}\hspace{0.6cm} {\rm supp}(f_X) = \{ x: f_X(x) > 0 \} | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | Verwendet man den natürlichen Logarithmus, so ist die Pseudo–Einheit „nat” anzufügen. Ist das Ergebnis dagegen in „bit” gefragt, so ist der <i>Logarithmus dualis</i> ⇒ „log<sub>2</sub>” zu verwenden. | + | *Verwendet man den ''natürlichen Logarithmus'', so ist die Pseudo–Einheit „nat” anzufügen. |

| + | *Ist das Ergebnis dagegen in „bit” gefragt, so ist der <i>Logarithmus dualis</i> ⇒ „log<sub>2</sub>” zu verwenden. | ||

| + | |||

| + | |||

| + | In der vierten Teilaufgabe wird die neue Zufallsgröße $Z = A \cdot Y$ betrachtet. Der WDF–Parameter $A$ ist so zu bestimmen, dass die differentielle Entropie der neuen Zufallsgröße $Z$</i> genau 1 bit ergibt:<br> | ||

| + | :$$h(Z) = h (A \cdot Y) = h (Y) + {\rm log}_2 \hspace{0.1cm} (A) = 1\,{\rm bit} \hspace{0.05cm}.$$ | ||

| + | |||

| + | |||

| + | ''Hinweise:'' | ||

| + | *Die Aufgabe gehört zum Kapitel [[Informationstheorie/Differentielle_Entropie|Differentielle Entropie]]. | ||

| + | *Nützliche Hinweise zur Lösung dieser Aufgabe und weitere Informationen zu den wertkontinuierlichen Zufallsgrößen finden Sie im Kapitel „Kontinuierliche Zufallsgrößen” des Buches [[Stochastische Signaltheorie]]. | ||

| + | *Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein. | ||

| + | *Vorgegeben ist das folgende unbestimmte Integral: | ||

| + | :$$\int \xi \cdot {\rm ln} \hspace{0.1cm} (\xi)\hspace{0.1cm}{\rm d}\xi = | ||

| + | \xi^2 \cdot \left [1/2 \cdot {{\rm ln} \hspace{0.1cm} (\xi)} - | ||

| + | {1}/{4}\right ] \hspace{0.05cm}.$$ | ||

| + | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

===Fragebogen=== | ===Fragebogen=== | ||

<quiz display=simple> | <quiz display=simple> | ||

| − | {Berechnen Sie die differentielle Entropie der Zufallsgröße | + | {Berechnen Sie die differentielle Entropie der Zufallsgröße $X$ in „nat”. |

|type="{}"} | |type="{}"} | ||

| − | $h(X)$ | + | $h(X) \ = $ { 0.193 3% } $\ \rm nat$ |

{Welches Ergebnis erhält man mit der Pseudoeinheit „bit”? | {Welches Ergebnis erhält man mit der Pseudoeinheit „bit”? | ||

|type="{}"} | |type="{}"} | ||

| − | $h(X)$ | + | $h(X) \ = $ { 0.279 3% } $\ \rm bit$ |

| − | {Berechnen Sie die differentielle Entropie der Zufallsgröße | + | {Berechnen Sie die differentielle Entropie der Zufallsgröße $Y$. |

|type="{}"} | |type="{}"} | ||

| − | $h(Y)$ | + | $h(Y) \ = $ { 0.721 3% } $\ \rm bit$ |

| − | {Bestimmen Sie den WDF–Parameter | + | {Bestimmen Sie den WDF–Parameter $A$, so dass $h(Z) = h (A \cdot Y) = 1 \ \rm bit$ gilt. |

|type="{}"} | |type="{}"} | ||

| − | $ h(Z) = 1 bit: A$ | + | $h(Z) = 1 \ \rm bit\text{:} \ \ A\ = $ { 1.213 3% } |

Revision as of 12:15, 6 April 2017

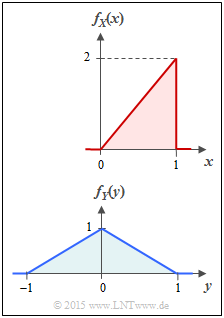

Betrachtet werden zwei Wahrscheinlichkeitsdichtefunktionen (kurz WDF) mit dreieckförmigem Verlauf.

- Die Zufallsgröße $X$ ist auf den Wertebereich von $0$ und $1$ begrenzt, und es gilt für die WDF (obere Skizze):

- $$f_X(x) = \left\{ \begin{array}{c} 2x \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} 0 \le x \le 1 \\ {\rm sonst} \\ \end{array} \hspace{0.05cm}.$$

- Die Zufallsgröße $Y$ besitzt gemäß der unteren Skizze die folgende WDF:

- $$f_Y(y) = \left\{ \begin{array}{c} 1 - |y| \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.1cm} |y| \le 1 \\ {\rm sonst} \\ \end{array} \hspace{0.05cm}.$$

- Der Zusammenhang zwischen den zwei Zufallsgrößen ist durch die Gleichung $X = |Y|$ gegeben.

Für beide Zufallsgrößen soll jeweils die differentielle Entropie ermittelt werden. Beispielsweise lautet die entsprechende Gleichung für die Zufallsgröße $X$:

- $$h(X) = \hspace{0.1cm} - \hspace{-0.45cm} \int\limits_{{\rm supp}\hspace{0.03cm}(\hspace{-0.03cm}f_X)} \hspace{-0.35cm} f_X(x) \cdot {\rm log} \hspace{0.1cm} [ f_X(x) ] \hspace{0.1cm}{\rm d}x \hspace{0.6cm}{\rm mit}\hspace{0.6cm} {\rm supp}(f_X) = \{ x: f_X(x) > 0 \} \hspace{0.05cm}.$$

- Verwendet man den natürlichen Logarithmus, so ist die Pseudo–Einheit „nat” anzufügen.

- Ist das Ergebnis dagegen in „bit” gefragt, so ist der Logarithmus dualis ⇒ „log2” zu verwenden.

In der vierten Teilaufgabe wird die neue Zufallsgröße $Z = A \cdot Y$ betrachtet. Der WDF–Parameter $A$ ist so zu bestimmen, dass die differentielle Entropie der neuen Zufallsgröße $Z$ genau 1 bit ergibt:

- $$h(Z) = h (A \cdot Y) = h (Y) + {\rm log}_2 \hspace{0.1cm} (A) = 1\,{\rm bit} \hspace{0.05cm}.$$

Hinweise:

- Die Aufgabe gehört zum Kapitel Differentielle Entropie.

- Nützliche Hinweise zur Lösung dieser Aufgabe und weitere Informationen zu den wertkontinuierlichen Zufallsgrößen finden Sie im Kapitel „Kontinuierliche Zufallsgrößen” des Buches Stochastische Signaltheorie.

- Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein.

- Vorgegeben ist das folgende unbestimmte Integral:

- $$\int \xi \cdot {\rm ln} \hspace{0.1cm} (\xi)\hspace{0.1cm}{\rm d}\xi = \xi^2 \cdot \left [1/2 \cdot {{\rm ln} \hspace{0.1cm} (\xi)} - {1}/{4}\right ] \hspace{0.05cm}.$$

Fragebogen

Musterlösung

Wir haben hierbei „2” durch C ersetzt ⇒ Verallgemeinerung, um in der Teilaufgabe (c) die nachfolgende Berechnung nochmals nutzen zu können.

Da die differentielle Entropie in „nat” gesucht ist, verwenden wir den natürlichen Logarithmus. Mit der Substitution ξ = C · x erhalten wir folgendes Integral: $$h_{\rm nat}(X) \hspace{-0.15cm} = \hspace{-0.15cm} \hspace{0.1cm} - \int_{0}^{1} \hspace{0.1cm} C \cdot x \cdot {\rm ln} \hspace{0.1cm} [ C \cdot x ] \hspace{0.1cm}{\rm d}x = \hspace{0.1cm} - \hspace{0.1cm}\frac{1}{C} \cdot \int_{0}^{C} \hspace{0.1cm} \xi \cdot {\rm ln} \hspace{0.1cm} [ \xi ] \hspace{0.1cm}{\rm d}\xi $$ $$\ = \hspace{-0.15cm} - \hspace{0.1cm}\frac{\xi^2}{C} \cdot \left [ \frac{{\rm ln} \hspace{0.1cm} (\xi)}{2} - \frac{1}{4}\right ]_{\xi = 0}^{\xi = C} \hspace{0.05cm}$$ Hierbei wurde das vorne angegebene unbestimmte Integral benutzt. Nach Einsetzen der Grenzen erhält man hieraus unter Berücksichtigung von C = 2: $$h_{\rm nat}(X) \hspace{-0.15cm} = \hspace{-0.15cm} - C/2 \cdot \left [ {\rm ln} \hspace{0.1cm} (C) - 1/2 \right ] = - {\rm ln} \hspace{0.1cm} (2) + 1/2 = - {\rm ln} \hspace{0.1cm} (2) + 1/2 \cdot {\rm ln} \hspace{0.1cm} ({\rm e}) =\\ = {\rm ln} \hspace{0.1cm} (\sqrt{\rm e}/2)\hspace{0.05cm} = {\rm ln} \hspace{0.1cm} (0.824) = - 0.193 \hspace{0.3cm} \Rightarrow\hspace{0.3cm} h(X) \hspace{0.15cm}\underline {= - 0.193\,{\rm nat}} \hspace{0.05cm}.$$

b) Allgemein gilt: $$h_{\rm bit}(X) = \frac{h_{\rm nat}(X)}{{\rm ln} \hspace{0.1cm} (2)\,{\rm nat/bit}} = - 0.279 \hspace{0.3cm} \Rightarrow\hspace{0.3cm} h(X) \hspace{0.15cm}\underline {= - 0.279\,{\rm bit}} \hspace{0.05cm}.$$ Diese Umrechnung kann man sich sparen, wenn man bereits im analytischen Ergebnis der Teilaufgabe a) direkt „ln” durch „log2” ersetzt: $$h(X) = \ {\rm log}_2 \hspace{0.1cm} (\sqrt{\rm e}/2)\hspace{0.05cm}, \hspace{1.3cm} {\rm Pseudo-Einheit\hspace{-0.1cm}:\hspace{0.15cm} bit} \hspace{0.05cm}.$$

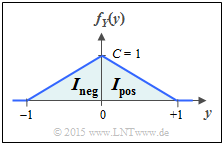

c) Wir verwenden wieder den natürlichen Logarithmus und teilen das Integral in zwei Teilintegrale auf: $$h(Y) = \hspace{0.1cm} - \hspace{-0.45cm} \int\limits_{{\rm supp} \hspace{0.03cm}( \hspace{-0.03cm}f_Y)} \hspace{-0.35cm} f_Y(y) \cdot {\rm ln} \hspace{0.1cm} [ f_Y(y) ] \hspace{0.1cm}{\rm d}y = I_{\rm neg} + I_{\rm pos} \hspace{0.05cm}.$$

Das erste Integral (Bereich –1 ≤ y ≤ 0) ist formgleich mit dem der Teilaufgabe (a) und gegenüber diesem nur verschoben, was das Ergebnis nicht beeinflusst. Zu berücksichtigen ist nun die Höhe C = 1 anstelle von C = 2: $$I_{\rm neg} =- C/2 \cdot \left [ {\rm ln} \hspace{0.1cm} (C) - 1/2 \right ] = -1/2 \cdot \left [ {\rm ln} \hspace{0.1cm} (1) - 1/2 \cdot {\rm ln} \hspace{0.1cm} ({\rm e}) \right ]= 1/4 \cdot {\rm ln} \hspace{0.1cm} ({\rm e}) \hspace{0.05cm}.$$

Der zweite Integrand ist bis auf eine Verschiebung und Spiegelung identisch mit dem ersten. Außerdem überlappen sich die Integrationsintervalle nicht ⇒ Ipos = Ineg: $$h_{\rm nat}(Y) = 2 \cdot I_{\rm neg} = 1/2 \cdot {\rm ln} \hspace{0.1cm} ({\rm e}) = {\rm ln} \hspace{0.1cm} (\sqrt{\rm e}) $$ $$\Rightarrow\hspace{0.3cm}h_{\rm bit}(Y) = {\rm log}_2 \hspace{0.1cm} (\sqrt{\rm e}) \hspace{0.3cm} \Rightarrow\hspace{0.3cm} h(Y) = {\rm log}_2 \hspace{0.1cm} (1.649)\hspace{0.15cm}\underline {= 0.721\,{\rm bit}}\hspace{0.05cm}.$$

d) Für die differentielle Entropie der Zufallsgröße Z = A · Y gilt allgemein: $$h(Z) = h(A \cdot Y) = h(Y) + {\rm log}_2 \hspace{0.1cm} (A) \hspace{0.05cm}.$$ Aus der Forderung h(Z) = 1 bit und dem Ergebnis der Teilaufgabe (c) folgt somit: $${\rm log}_2 \hspace{0.1cm} (A) = 1\,{\rm bit} - 0.721 \,{\rm bit} = 0.279 \,{\rm bit} \hspace{0.3cm} \Rightarrow\hspace{0.3cm} A = 2^{0.279}\hspace{0.15cm}\underline {= 1.213} \hspace{0.05cm}.$$