Difference between revisions of "Aufgaben:Exercise 1.1: Entropy of the Weather"

| Line 6: | Line 6: | ||

Eine Wetterstation fragt täglich verschiedene Regionen ab und bekommt als Antwort jeweils eine Meldung $x$ zurück, nämlich | Eine Wetterstation fragt täglich verschiedene Regionen ab und bekommt als Antwort jeweils eine Meldung $x$ zurück, nämlich | ||

| − | * $x = \ | + | * $x = \rm B$: Das Wetter ist eher schlecht. |

| − | * $x = \ | + | * $x = \rm G$: Das Wetter ist eher gut. |

| − | Die Daten wurden über viele Jahre für verschiedene Gebiete in Dateien abgelegt, so dass die Entropien der $\ | + | Die Daten wurden über viele Jahre für verschiedene Gebiete in Dateien abgelegt, so dass die Entropien der $\rm B/G$–Folgen ermittelt werden können: |

:$$H = p_{\rm B} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm B}} + p_{\rm G} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm G}}$$ | :$$H = p_{\rm B} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm B}} + p_{\rm G} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm G}}$$ | ||

| Line 76: | Line 76: | ||

===Musterlösung=== | ===Musterlösung=== | ||

{{ML-Kopf}} | {{ML-Kopf}} | ||

| − | + | '''(1)''' Bei der Datei „Durchwachsen” sind die beiden Wahrscheinlichkeiten gleich: $p_{\rm B} = p_{\rm G} =0.5$. Damit ergibt sich für die Entropie: | |

:$$H_{\rm D} = 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} + 0.5 \cdot | :$$H_{\rm D} = 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} + 0.5 \cdot | ||

{\rm log}_2\hspace{0.1cm}\frac{1}{0.5} \hspace{0.15cm}\underline {= 1\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} \hspace{0.15cm}\underline {= 1\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | ||

| − | + | '''(2)''' Mit $p_{\rm B} = 0.$, und $p_{\rm G} =0.2$ erhält man einen kleineren Entropiewert: | |

| − | :$$H_{\rm R} | + | :$$H_{\rm R} = 0.8 \cdot {\rm log}_2\hspace{0.05cm}\frac{5}{4} + 0.2 \cdot {\rm log}_2\hspace{0.05cm}\frac{5}{1}= |

| − | 0.8 \cdot{\rm log}_2\hspace{0. | + | 0.8 \cdot{\rm log}_2\hspace{0.05cm}5 - 0.8 \cdot {\rm log}_2\hspace{0.05cm}4 + 0.2 \cdot {\rm log}_2 \hspace{0.05cm} 5 = |

| − | + | {\rm log}_2\hspace{0.05cm}5 - 0.8 \cdot | |

| − | {\rm log}_2\hspace{0.1cm}4 = \frac{{\rm lg} \hspace{0.1cm}5}{{\rm lg}\hspace{0.1cm}2 | + | {\rm log}_2\hspace{0.1cm}4 = \frac{{\rm lg} \hspace{0.1cm}5}{{\rm lg}\hspace{0.1cm}2} - 1.6 \hspace{0.15cm} |

\underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | ||

| − | + | '''(3)''' In der Datei „Angenehm” sind die Wahrscheinlichkeiten gegenüber der Datei „Regenloch” genau vertauscht. Durch diese Vertauschung wird die Entropie jedoch nicht verändert: | |

:$$H_{\rm A} = H_{\rm R} \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | :$$H_{\rm A} = H_{\rm R} \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | ||

| − | + | '''(4)''' Mit $p_{\rm B} = 1/30$ und $p_{\rm G} =29/30$ ergeben sich folgende Informationsgehalte: | |

:$$I_{\rm B} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}30 = | :$$I_{\rm B} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}30 = | ||

\frac{{\rm lg}\hspace{0.1cm}30}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} | \frac{{\rm lg}\hspace{0.1cm}30}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} | ||

| − | \underline {= 4.907\,{\rm bit/Anfrage}}\hspace{0.05cm}, | + | \underline {= 4.907\,{\rm bit/Anfrage}}\hspace{0.05cm},$$ |

| − | I_{\rm G} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}\frac{30}{29} = | + | :$$I_{\rm G} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}\frac{30}{29} = |

\frac{{\rm lg}\hspace{0.1cm}1.034}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} | \frac{{\rm lg}\hspace{0.1cm}1.034}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} | ||

\underline {= 0.049\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | \underline {= 0.049\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | ||

| − | + | '''(5)''' Die Entropie $H_{\rm P}$ ist der mittlere Informationsgehalt der beiden Ereignisse $\rm B$ und $\rm G$: | |

:$$H_{\rm P} = \frac{1}{30} \cdot 4.907 + \frac{29}{30} \cdot 0.049 = 0.164 + 0.047 | :$$H_{\rm P} = \frac{1}{30} \cdot 4.907 + \frac{29}{30} \cdot 0.049 = 0.164 + 0.047 | ||

\hspace{0.15cm} | \hspace{0.15cm} | ||

\underline {= 0.211\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | \underline {= 0.211\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$ | ||

| − | + | Obwohl das Ereignis $\rm B$ seltener auftritt als $\rm G$, ist sein Beitrag zur Entropie größer. | |

| − | |||

| − | :Aufgrund dieser statistischen Abhängigkeit innerhalb der | + | '''(6)''' Richtig sind die <u>Aussagen 1 und 3</u>: |

| + | *Die Ereignisse $\rm B$ und $\rm G$ sind bei der Datei „Unbekannt” tatsächlich gleichwahrscheinlich: Die 60 dargestellten Symbole teilen sich auf in 30 mal $\rm B$ und 30 mal& $\rm GB$. | ||

| + | *Es bestehen nun aber starke statistische Bindungen innerhalb der zeitlichen Folge. Nach längeren Schönwetterperioden folgen meist viele schlechte Tage am Stück. | ||

| + | *Aufgrund dieser statistischen Abhängigkeit innerhalb der $\rm B/G$–Folgen–Folge ist $H_\text{U} = 0.72 \; \rm bit/Anfrage$ kleiner als $H_\text{D} = 1 \; \rm bit/Anfrage$. | ||

| + | *$H_\text{D}$ ist gleichzeitig das Maximum für $M = 2$ ⇒ die letzte Aussage ist mit Sicherheit falsch. | ||

{{ML-Fuß}} | {{ML-Fuß}} | ||

Revision as of 14:57, 25 April 2017

Eine Wetterstation fragt täglich verschiedene Regionen ab und bekommt als Antwort jeweils eine Meldung $x$ zurück, nämlich

- $x = \rm B$: Das Wetter ist eher schlecht.

- $x = \rm G$: Das Wetter ist eher gut.

Die Daten wurden über viele Jahre für verschiedene Gebiete in Dateien abgelegt, so dass die Entropien der $\rm B/G$–Folgen ermittelt werden können:

- $$H = p_{\rm B} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm B}} + p_{\rm G} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm G}}$$

mit dem Logarithmus dualis

- $${\rm log}_2\hspace{0.1cm}p=\frac{{\rm lg}\hspace{0.1cm}p}{{\rm lg}\hspace{0.1cm}2}\hspace{0.3cm} \left ( = {\rm ld}\hspace{0.1cm}p \right ) \hspace{0.05cm}.$$

„lg” kennzeichnet hierbei den Logarithmus zur Basis 10. Zu erwähnen ist ferner, dass jeweils noch die Pseudoeinheit „bit/Anfrage” anzufügen ist.

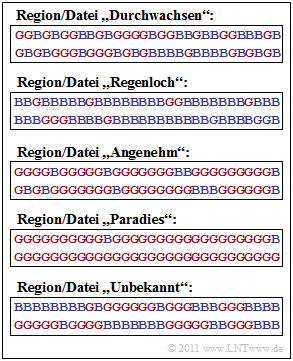

Die Grafik zeigt diese binären Folgen jeweils für 60 Tage und folgende Regionen:

- Region „Durchwachsen”: $p_{\rm B} = p_{\rm G} =0.5$,

- Region „Regenloch”: $p_{\rm B} = 0.8, \; p_{\rm G} =0.2$,

- Region „Angenehm”: $p_{\rm B} = 0.2, \; p_{\rm G} =0.8$,

- Region „Paradies”: $p_{\rm B} = 1/30, \; p_{\rm G} =29/30$.

Schließlich ist auch noch die Datei „Unbekannt” angegeben, deren statistische Eigenschaften zu schätzen sind.

Hinweise:

- Die Aufgabe gehört zum Kapitel Gedächtnislose Nachrichtenquellen.

- Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein.

- Für die vier ersten Dateien wird vorausgesetzt, dass die Ereignisse $\rm B$ und $\rm G$ statistisch unabhängig seien, eine für die Wetterpraxis allerdings eher unrealistische Annahme.

Fragebogen

Musterlösung

- $$H_{\rm D} = 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} + 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} \hspace{0.15cm}\underline {= 1\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

(2) Mit $p_{\rm B} = 0.$, und $p_{\rm G} =0.2$ erhält man einen kleineren Entropiewert:

- $$H_{\rm R} = 0.8 \cdot {\rm log}_2\hspace{0.05cm}\frac{5}{4} + 0.2 \cdot {\rm log}_2\hspace{0.05cm}\frac{5}{1}= 0.8 \cdot{\rm log}_2\hspace{0.05cm}5 - 0.8 \cdot {\rm log}_2\hspace{0.05cm}4 + 0.2 \cdot {\rm log}_2 \hspace{0.05cm} 5 = {\rm log}_2\hspace{0.05cm}5 - 0.8 \cdot {\rm log}_2\hspace{0.1cm}4 = \frac{{\rm lg} \hspace{0.1cm}5}{{\rm lg}\hspace{0.1cm}2} - 1.6 \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

(3) In der Datei „Angenehm” sind die Wahrscheinlichkeiten gegenüber der Datei „Regenloch” genau vertauscht. Durch diese Vertauschung wird die Entropie jedoch nicht verändert:

- $$H_{\rm A} = H_{\rm R} \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

(4) Mit $p_{\rm B} = 1/30$ und $p_{\rm G} =29/30$ ergeben sich folgende Informationsgehalte:

- $$I_{\rm B} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}30 = \frac{{\rm lg}\hspace{0.1cm}30}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} \underline {= 4.907\,{\rm bit/Anfrage}}\hspace{0.05cm},$$

- $$I_{\rm G} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}\frac{30}{29} = \frac{{\rm lg}\hspace{0.1cm}1.034}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} \underline {= 0.049\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

(5) Die Entropie $H_{\rm P}$ ist der mittlere Informationsgehalt der beiden Ereignisse $\rm B$ und $\rm G$:

- $$H_{\rm P} = \frac{1}{30} \cdot 4.907 + \frac{29}{30} \cdot 0.049 = 0.164 + 0.047 \hspace{0.15cm} \underline {= 0.211\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

Obwohl das Ereignis $\rm B$ seltener auftritt als $\rm G$, ist sein Beitrag zur Entropie größer.

(6) Richtig sind die Aussagen 1 und 3:

- Die Ereignisse $\rm B$ und $\rm G$ sind bei der Datei „Unbekannt” tatsächlich gleichwahrscheinlich: Die 60 dargestellten Symbole teilen sich auf in 30 mal $\rm B$ und 30 mal& $\rm GB$.

- Es bestehen nun aber starke statistische Bindungen innerhalb der zeitlichen Folge. Nach längeren Schönwetterperioden folgen meist viele schlechte Tage am Stück.

- Aufgrund dieser statistischen Abhängigkeit innerhalb der $\rm B/G$–Folgen–Folge ist $H_\text{U} = 0.72 \; \rm bit/Anfrage$ kleiner als $H_\text{D} = 1 \; \rm bit/Anfrage$.

- $H_\text{D}$ ist gleichzeitig das Maximum für $M = 2$ ⇒ die letzte Aussage ist mit Sicherheit falsch.