Difference between revisions of "Aufgaben:Exercise 3.7: Some Entropy Calculations"

| Line 16: | Line 16: | ||

Daraus lassen sich gemäß dem obigen Schema – dargestellt für die Zufallsgröße $XY$ – auch folgende Beschreibungsgrößen sehr einfach bestimmen: | Daraus lassen sich gemäß dem obigen Schema – dargestellt für die Zufallsgröße $XY$ – auch folgende Beschreibungsgrößen sehr einfach bestimmen: | ||

* die bedingten Entropien (englisch: ''Conditional Entropies''): | * die bedingten Entropien (englisch: ''Conditional Entropies''): | ||

| − | :$$H(X \hspace{0.05cm}|\hspace{0.05cm} Y) = -{\rm E}[\log_2 P_{ X \hspace{0.05cm}|\hspace{0.05cm} }( X \hspace{0.05cm}|\hspace{0.05cm} Y)],$$ | + | :$$H(X \hspace{0.05cm}|\hspace{0.05cm} Y) = -{\rm E}[\log_2 P_{ X \hspace{0.05cm}|\hspace{0.05cm}Y }( X \hspace{0.05cm}|\hspace{0.05cm} Y)],$$ |

| − | :$$H(Y \hspace{0.05cm}|\hspace{0.05cm} | + | :$$H(Y \hspace{0.05cm}|\hspace{0.05cm} X) = -{\rm E}[\log_2 P_{ Y \hspace{0.05cm}|\hspace{0.05cm} X }( Y \hspace{0.05cm}|\hspace{0.05cm} X)],$$ |

* die Transinformation (englisch: Mutual Information) zwischen $X$ und $Y$: | * die Transinformation (englisch: Mutual Information) zwischen $X$ und $Y$: | ||

| − | :$$I(X;Y) = {\rm E}[\ | + | :$$I(X;Y) = {\rm E} \hspace{-0.08cm}\left [ \hspace{0.02cm}{\rm log}_2 \hspace{0.1cm} \frac{P_{XY}(X, Y)} |

| + | {P_{X}(X) \cdot P_{Y}(Y) }\right ] \hspace{0.05cm}.$$ | ||

Abschließend sind qualitative Aussagen hinsichtlich der zweiten Zufallsgröße $UV$ zu verifizieren. | Abschließend sind qualitative Aussagen hinsichtlich der zweiten Zufallsgröße $UV$ zu verifizieren. | ||

| + | |||

| + | |||

''Hinweise:'' | ''Hinweise:'' | ||

| Line 64: | Line 67: | ||

{{ML-Kopf}} | {{ML-Kopf}} | ||

| − | '''1 | + | '''(1)''' Aus der gegebenen Verbundwahrscheinlichkeit erhält man |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | $H( | + | :$$H(XY) = 0.18 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.18} + 0.16\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.16}+ \hspace{-0.15cm} |

| + | 0.02\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.02}+ | ||

| + | 0.64\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.64} | ||

| + | \hspace{0.15cm} \underline {= 1.393\,{\rm (bit)}} | ||

| + | \hspace{0.05cm}.$$ | ||

| − | $H(Y) = 0 | + | '''(2)''' Die 1D–Wahrscheinlichkeitsfunktionen lauten $P_X(X) = [0.2, 0.8]$ und $P_Y(Y) = [0.34, 0.66]$. Daraus folgt: |

| + | :$$H(X) = 0.2 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.2} + 0.8\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.8}\hspace{0.15cm} \underline {= 0.722\,{\rm (bit)}} \hspace{0.05cm},$$ | ||

| + | :$$H(Y) =0.34 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.34} + 0.66\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.66}\hspace{0.15cm} \underline {= 0.925\,{\rm (bit)}} \hspace{0.05cm}.$$ | ||

| − | '''3 | + | '''(3)''' Aus der Grafik auf der Angabenseite erkennt man den Zusammenhang: |

| + | :$$I(X;Y) = H(X) + H(Y) - H(XY) = 0.722\,{\rm (bit)} + 0.925\,{\rm (bit)}- 1.393\,{\rm (bit)}\hspace{0.15cm} \underline {= 0.254\,{\rm (bit)}} \hspace{0.05cm}.$$ | ||

| − | |||

| − | |||

| + | '''(4)''' Ebenso gilt entsprechend der Grafik auf der Angabenseite: | ||

| + | :$$H(X \hspace{-0.1cm}\mid \hspace{-0.08cm} Y) = H(XY) - H(Y) = 1.393- 0.925\hspace{0.15cm} \underline {= 0.468\,{\rm (bit)}} \hspace{0.05cm},$$ | ||

| + | :$$H(Y \hspace{-0.1cm}\mid \hspace{-0.08cm} X) = H(XY) - H(X) = 1.393- 0.722\hspace{0.15cm} \underline {= 0.671\,{\rm (bit)}} \hspace{0.05cm}$$ | ||

| − | + | Die linke Grafik fasst die Ergebnisse der Teilaufgaben (1), ... , (4) maßstabsgetreu zusammen. Grau hinterlegt ist die Verbundentropie und gelb die Transinformation. Eine rote Hinterlegung bezieht sich auf die Zufallsgröße $X$, eine grüne auf $Y$. Schraffierte Felder deuten auf eine bedingte Entropie hin. | |

| − | + | [[File:P_ID2767__Inf_A_3_6d.png|Entropiewerte für die Zufallsgrößen <i>XY</i> und <i>UV</i>]] | |

| − | |||

| − | Die | + | Die rechte Grafik beschreibt den gleichen Sachverhalt für die Zufallsgröße $UV$ ⇒ Teilaufgabe (5). |

| − | |||

| − | |||

| − | '''5 | + | '''(5)''' Richtig sind demzufolge die Aussagen 1, 2 und 4: |

| − | + | *Man erkennt die Gültigkeit von $P_{ UV } (⋅) = P_U (⋅) · P_V(⋅)$ ⇒ Transinformation $I(U; V) = 0$ daran, dass die zweite Zeile der $P_{ UV }$–Matrix sich von der ersten Zeile nur durch einen konstanten Faktor ($4$) unterscheidet. | |

| − | + | *Es ergeben sich gleiche 1D–Wahrscheinlichkeitsfunktionen wie für die Zufallsgröße $XY$ ⇒ $P_U(U) = [0.2, 0.8]$, $P_V(V) = [0.34, 0.66]$. | |

| − | + | *Deshalb ist auch $H(U) = H(X) = 0.722\ \rm bit$ und $H(V) = H(Y) = 0.925 \ \rm bit$. | |

| + | * Hier gilt aber nun für die Verbundentropie: $H(UV) = H(U) + H(V) ≠ H(XY)$. | ||

{{ML-Fuß}} | {{ML-Fuß}} | ||

Revision as of 13:32, 1 June 2017

Wir betrachten die beiden Zufallsgrößen $XY$ und $UV$ mit den folgenden 2D-Wahrscheinlichkeitsfunktionen:

- $$P_{XY}(X, Y) = \begin{pmatrix} 0.18 & 0.16\\ 0.02 & 0.64 \end{pmatrix}\hspace{0.05cm} \hspace{0.05cm}$$

- $$P_{UV}(U, V) \hspace{0.05cm}= \begin{pmatrix} 0.068 & 0.132\\ 0.272 & 0.528 \end{pmatrix}\hspace{0.05cm}$$

Für die Zufallsgröße $XY$sollen in dieser Aufgabe berechnet werden:

- die Verbundentropie (englisch: Joint Entropy):

- $$H(XY) = -{\rm E}[\log_2 P_{ XY }( X,Y)],$$

- die beiden Einzelentropien:

- $$H(X) = -{\rm E}[\log_2 P_X( X)],$$

- $$H(Y) = -{\rm E}[\log_2 P_Y( Y)].$$

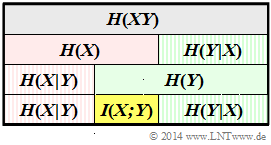

Daraus lassen sich gemäß dem obigen Schema – dargestellt für die Zufallsgröße $XY$ – auch folgende Beschreibungsgrößen sehr einfach bestimmen:

- die bedingten Entropien (englisch: Conditional Entropies):

- $$H(X \hspace{0.05cm}|\hspace{0.05cm} Y) = -{\rm E}[\log_2 P_{ X \hspace{0.05cm}|\hspace{0.05cm}Y }( X \hspace{0.05cm}|\hspace{0.05cm} Y)],$$

- $$H(Y \hspace{0.05cm}|\hspace{0.05cm} X) = -{\rm E}[\log_2 P_{ Y \hspace{0.05cm}|\hspace{0.05cm} X }( Y \hspace{0.05cm}|\hspace{0.05cm} X)],$$

- die Transinformation (englisch: Mutual Information) zwischen $X$ und $Y$:

- $$I(X;Y) = {\rm E} \hspace{-0.08cm}\left [ \hspace{0.02cm}{\rm log}_2 \hspace{0.1cm} \frac{P_{XY}(X, Y)} {P_{X}(X) \cdot P_{Y}(Y) }\right ] \hspace{0.05cm}.$$

Abschließend sind qualitative Aussagen hinsichtlich der zweiten Zufallsgröße $UV$ zu verifizieren.

Hinweise:

- Die Aufgabe gehört zum Kapitel Verschiedene Entropien zweidimensionaler Zufallsgrößen.

- Insbesondere wird Bezug genommen auf die Seiten Bedingte Wahrscheinlichkeit und bedingte Entropie sowie Transinformation zwischen zwei Zufallsgrößen.

- Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein.

Fragebogen

Musterlösung

(1) Aus der gegebenen Verbundwahrscheinlichkeit erhält man

- $$H(XY) = 0.18 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.18} + 0.16\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.16}+ \hspace{-0.15cm} 0.02\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.02}+ 0.64\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.64} \hspace{0.15cm} \underline {= 1.393\,{\rm (bit)}} \hspace{0.05cm}.$$

(2) Die 1D–Wahrscheinlichkeitsfunktionen lauten $P_X(X) = [0.2, 0.8]$ und $P_Y(Y) = [0.34, 0.66]$. Daraus folgt:

- $$H(X) = 0.2 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.2} + 0.8\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.8}\hspace{0.15cm} \underline {= 0.722\,{\rm (bit)}} \hspace{0.05cm},$$

- $$H(Y) =0.34 \cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.34} + 0.66\cdot {\rm log}_2 \hspace{0.1cm} \frac{1}{0.66}\hspace{0.15cm} \underline {= 0.925\,{\rm (bit)}} \hspace{0.05cm}.$$

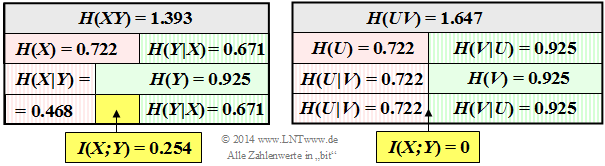

(3) Aus der Grafik auf der Angabenseite erkennt man den Zusammenhang:

- $$I(X;Y) = H(X) + H(Y) - H(XY) = 0.722\,{\rm (bit)} + 0.925\,{\rm (bit)}- 1.393\,{\rm (bit)}\hspace{0.15cm} \underline {= 0.254\,{\rm (bit)}} \hspace{0.05cm}.$$

(4) Ebenso gilt entsprechend der Grafik auf der Angabenseite:

- $$H(X \hspace{-0.1cm}\mid \hspace{-0.08cm} Y) = H(XY) - H(Y) = 1.393- 0.925\hspace{0.15cm} \underline {= 0.468\,{\rm (bit)}} \hspace{0.05cm},$$

- $$H(Y \hspace{-0.1cm}\mid \hspace{-0.08cm} X) = H(XY) - H(X) = 1.393- 0.722\hspace{0.15cm} \underline {= 0.671\,{\rm (bit)}} \hspace{0.05cm}$$

Die linke Grafik fasst die Ergebnisse der Teilaufgaben (1), ... , (4) maßstabsgetreu zusammen. Grau hinterlegt ist die Verbundentropie und gelb die Transinformation. Eine rote Hinterlegung bezieht sich auf die Zufallsgröße $X$, eine grüne auf $Y$. Schraffierte Felder deuten auf eine bedingte Entropie hin.

Die rechte Grafik beschreibt den gleichen Sachverhalt für die Zufallsgröße $UV$ ⇒ Teilaufgabe (5).

(5) Richtig sind demzufolge die Aussagen 1, 2 und 4:

- Man erkennt die Gültigkeit von $P_{ UV } (⋅) = P_U (⋅) · P_V(⋅)$ ⇒ Transinformation $I(U; V) = 0$ daran, dass die zweite Zeile der $P_{ UV }$–Matrix sich von der ersten Zeile nur durch einen konstanten Faktor ($4$) unterscheidet.

- Es ergeben sich gleiche 1D–Wahrscheinlichkeitsfunktionen wie für die Zufallsgröße $XY$ ⇒ $P_U(U) = [0.2, 0.8]$, $P_V(V) = [0.34, 0.66]$.

- Deshalb ist auch $H(U) = H(X) = 0.722\ \rm bit$ und $H(V) = H(Y) = 0.925 \ \rm bit$.

- Hier gilt aber nun für die Verbundentropie: $H(UV) = H(U) + H(V) ≠ H(XY)$.