Difference between revisions of "Aufgaben:Exercise 3.7: Some Entropy Calculations"

| Line 6: | Line 6: | ||

Wir betrachten die beiden Zufallsgrößen $XY$ und $UV$ mit den folgenden 2D-Wahrscheinlichkeitsfunktionen: | Wir betrachten die beiden Zufallsgrößen $XY$ und $UV$ mit den folgenden 2D-Wahrscheinlichkeitsfunktionen: | ||

| − | $$P_{XY}(X, Y) = \begin{pmatrix} 0.18 & 0.16\\ 0.02 & 0.64 \end{pmatrix}\hspace{0.05cm} \hspace{0.05cm}$$ | + | $$P_{XY}(X, Y) = \begin{pmatrix} 0.18 & 0.16\\ 0.02 & 0.64 \end{pmatrix}\hspace{0.05cm} \hspace{0.05cm}$$ |

| − | $$P_{UV}(U, V) \hspace{0.05cm}= \begin{pmatrix} 0.068 & 0.132\\ 0.272 & 0.528 \end{pmatrix}\hspace{0.05cm}$$ | + | $$P_{UV}(U, V) \hspace{0.05cm}= \begin{pmatrix} 0.068 & 0.132\\ 0.272 & 0.528 \end{pmatrix}\hspace{0.05cm}$$ |

Für die Zufallsgröße $XY$sollen in dieser Aufgabe berechnet werden: | Für die Zufallsgröße $XY$sollen in dieser Aufgabe berechnet werden: | ||

| Line 19: | Line 19: | ||

$$H(X) = -E[log_2 P_X( X)]$$ | $$H(X) = -E[log_2 P_X( X)]$$ | ||

$$H(Y) = -E[log_2 P_Y( Y)]$$ | $$H(Y) = -E[log_2 P_Y( Y)]$$ | ||

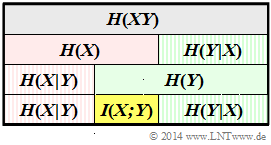

| + | Daraus lassen sich entsprechend dem obigen Schema – dargestellt für die Zufallsgröße $XY$ – noch die folgenden Beschreibungsgrößen sehr einfach bestimmen: | ||

| + | |||

| + | :* die bedingten Entropien (englisch: Conditional Entropies): | ||

| + | |||

| + | $H(X \mid Y) = -E[log_2 P_{ X \mid Y }( X \mid Y)]$ | ||

| + | |||

| + | $H(Y \mid Y) = -E[log_2 P_{ Y \mid X }( Y \mid X)]$ | ||

| + | |||

| + | :* die Transinformation (englisch: Mutual Information) zwischen $X$ und $Y$: | ||

| + | |||

| + | $I(X;Y) = E [log_2 \frac{P_{ XY }(X,Y)}{P_X(X) . P_Y(Y)}]$ | ||

| + | |||

| + | Abschließend sind qualitative Aussagen hinsichtlich der zweiten Zufallsgröße $UV$ zu verifizieren. | ||

| + | '''Hinwies:''' Die Aufgabe bezieht sich auf das Themengebiet von [http://en.lntwww.de/Informationstheorie/Verschiedene_Entropien_zweidimensionaler_Zufallsgr%C3%B6%C3%9Fen Kapitel 3.2]. | ||

| + | |||

| + | |||

Revision as of 14:49, 26 November 2016

Wir betrachten die beiden Zufallsgrößen $XY$ und $UV$ mit den folgenden 2D-Wahrscheinlichkeitsfunktionen:

$$P_{XY}(X, Y) = \begin{pmatrix} 0.18 & 0.16\\ 0.02 & 0.64 \end{pmatrix}\hspace{0.05cm} \hspace{0.05cm}$$

$$P_{UV}(U, V) \hspace{0.05cm}= \begin{pmatrix} 0.068 & 0.132\\ 0.272 & 0.528 \end{pmatrix}\hspace{0.05cm}$$

Für die Zufallsgröße $XY$sollen in dieser Aufgabe berechnet werden:

- die Verbundentropie (englisch: Joint Entropy):

$H(XY) = -E[log_2 P_{ XY }( X,Y)]$

- die beiden Einzelentropien:

$$H(X) = -E[log_2 P_X( X)]$$ $$H(Y) = -E[log_2 P_Y( Y)]$$ Daraus lassen sich entsprechend dem obigen Schema – dargestellt für die Zufallsgröße $XY$ – noch die folgenden Beschreibungsgrößen sehr einfach bestimmen:

- die bedingten Entropien (englisch: Conditional Entropies):

$H(X \mid Y) = -E[log_2 P_{ X \mid Y }( X \mid Y)]$

$H(Y \mid Y) = -E[log_2 P_{ Y \mid X }( Y \mid X)]$

- die Transinformation (englisch: Mutual Information) zwischen $X$ und $Y$:

$I(X;Y) = E [log_2 \frac{P_{ XY }(X,Y)}{P_X(X) . P_Y(Y)}]$

Abschließend sind qualitative Aussagen hinsichtlich der zweiten Zufallsgröße $UV$ zu verifizieren. Hinwies: Die Aufgabe bezieht sich auf das Themengebiet von Kapitel 3.2.

Fragebogen

Musterlösung