Contents

Prerequisites and mean values

Throughout the chapter "Linear Combinations of Random Variables" we make the following assumptions:

- The random variables $u$ and $v$ are zero mean each ⇒ $m_u = m_v = 0$ and also statistically independent of each other ⇒ $ρ_{uv} = 0$.

- The two random variables $u$ and $v$ each have equal standard deviation $σ$. No statement is made about the nature of the distribution.

- Let the two random variables $x$ and $y$ be linear combinations of $u$ and $v$, where:

- $$x=A \cdot u + B \cdot v + C,$$

- $$y=D \cdot u + E \cdot v + F.$$

Thus, for the (linear) mean values of the new random variables $x$ and $y$ we obtain according to the general rules of calculation for expected values:

- $$m_x =A \cdot m_u + B \cdot m_v + C =C,$$

- $$m_y =D \cdot m_u + E \cdot m_v + F =F.$$

Thus, the coefficients $C$ and $F$ give only the mean values of $x$ and $y$ Both are always set to zero in the following pages.

Resulting correlation coefficient

ResuLet us now consider the variances of the random variables according to the linear combinations.

- For the random variable $x$ holds independently of the parameter $C$:

- $$\sigma _x ^2 = {\rm E}\big[x ^{\rm 2}\big] = A^{\rm 2} \cdot {\rm E}\big[u^{\rm 2}\big] + B^{\rm 2} \cdot {\rm E}\big[v^{\rm 2}\big] + {\rm 2} \cdot A \cdot B \cdot {\rm E}\big[u \cdot v\big].$$

- The expected values of $u^2$ and $v^2$ are by definition equal to $σ^2$, respectively, because $u$ and $v$ are zero mean.

- Since $u$ and $v$ are moreover assumed to be statistically independent, one can also write for the expected value of the product:

- $${\rm E}\big[u \cdot v\big] = {\rm E}\big[u\big] \cdot {\rm E}\big[v\big] = m_u \cdot m_v = \rm 0.$$

- Thus, for the variances of the random variables formed by linear combinations, we obtain:

- $$\sigma _x ^2 =(A^2 + B^2) \cdot \sigma ^2,$$

- $$\sigma _y ^2 =(D^2 + E^2) \cdot \sigma ^2.$$

The covariance $μ_{xy}$ is identical to the joint moment $m_{xy}$ for zero mean random variables $x$ and $y$ ⇒ $C = F = 0$ :

- $$\mu_{xy } = m_{xy } = {\rm E}\big[x \cdot y\big] = {\rm E}\big[(A \cdot u + B \cdot v)\cdot (D \cdot u + E \cdot v)\big].$$

Note here that ${\rm E}\big[ \text{...} \big]$ denotes an expected value, while $E$ describes a variable.

$\text{Conclusion:}$ After evaluating this equation in an analogous manner to above, it follows:

- $$\mu_{xy } = (A \cdot D + B \cdot E) \cdot \sigma^{\rm 2 } \hspace{0.3cm}\rightarrow\hspace{0.3cm} \rho_{xy } = \frac{\rho_{xy } }{\sigma_x \cdot \sigma_y} = \frac {A \cdot D + B \cdot E}{\sqrt{(A^{\rm 2}+B^{\rm 2})(D^{\rm 2}+E^{\rm 2} ) } }. $$

We now exclude two special cases:

- $A = B = 0$ ⇒ $x ≡ 0$ as well as.

- $D = E = 0$ ⇒ $y ≡ 0$.

Then the above equation always yields unique values for the correlation coefficient in the range $-1 ≤ ρ_{xy} ≤ +1$.

$\text{Example 1:}$ If we set $A = E = 0$, we get the correlation coefficient $ρ_{xy} = 0$. This result is insightful:

- Now $x$ depends only on $v$ and $y$ depends exclusively on $u$ .

- But since $u$ and $v$ were assumed to be statistically independent, there are also no relationships between $x$ and $y$.

- Similarly, $ρ_{xy} = 0$ results for the combination $B = D = 0$.

$\text{Example 2:}$ The constellation $B = E = 0$ leads to the fact that both $x$ and $y$ depend only on $u$ Then the correlation coefficient is obtained:

- $$\rho_{xy } = \frac {A \cdot D }{\sqrt{A^{\rm 2}\cdot D^{\rm 2} } } = \frac {A \cdot D }{\vert A\vert \cdot D\vert } =\pm 1. $$

- If $A$ and $D$ have the same sign, then $ρ_{xy} = +1$.

- For different signs, the correlation coefficient is $-1$.

- Also, for $A = D = 0$ the coefficient $ρ_{xy} = ±1$ if $B \ne 0$ and $E \ne 0$ holds.

Erzeugung korrelierter Zufallsgrößen

Die Gleichungen der letzten Seite können zur Erzeugung einer zweidimensionalen Zufallsgröße $(x, y)$ mit vorgegebenen Kenngrößen $σ_x$, $σ_y$ und $ρ_{xy}$ genutzt werden.

- Werden außer diesen drei Sollwerten keine weiteren Voraussetzungen getroffen, so ist einer der vier Koeffizienten $A, \ B, \ D$ und $E$ frei wählbar.

- Im Folgenden wird stets willkürlich $E = 0$ gesetzt.

- Mit der weiteren Festlegung, dass die statistisch unabhängigen Zufallsgrößen $u$ und $v$ jeweils die Streuung $σ =1$ aufweisen, erhält man:

- $$D = \sigma_y, \hspace{0.5cm} A = \sigma_x \cdot \rho_{xy}, \hspace{0.5cm} B = \sigma_x \cdot \sqrt {1-\rho_{xy}^2}.$$

- Bei $σ ≠ 1$ sind diese Werte jeweils noch durch $σ$ zu dividieren.

$\text{Beispiel 3:}$ Wir gehen stets von mittelwertfreien Gaußschen Zufallsgrößen $u$ und $v$ aus. Beide besitzen die Varianz $σ^2 = 1$.

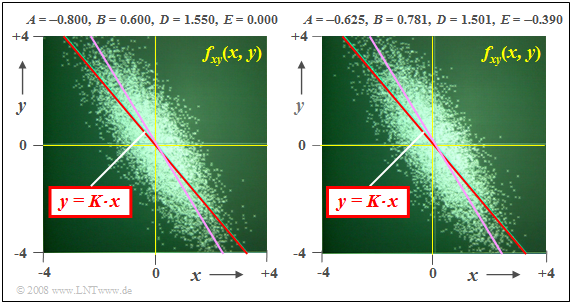

$(1)$ Zur Erzeugung einer 2D–Zufallsgröße mit den gewünschten Kennwerten $σ_x =1$, $σ_y = 1.55$ und $ρ_{xy} = -0.8$ eignet sich zum Beispiel der Parametersatz

- $$A = -0.8, \; B = 0.6, \; D = 1.55, \; E = 0.$$

- Dieser Parametersatz liegt der linken Grafik zugrunde.

- Die Korrelationsgerade $K(x)$ ist rot dargestellt.

- Sie verläuft unter einem Winkel von etwa $-50^\circ$.

- Violett eingezeichnet ist die Ellipsenhauptachse, die etwas oberhalb der Korrelationsgeraden liegt.

$(2)$ Der Parametersatz für die rechte Grafik lautet:

- $$A = -0.625,\; B = 0.781,\; D = 1.501,\; E = -0.390.$$

- Im statistischen Sinne erhält man das gleiche Resultat, auch wenn sich die beiden Punktwolken im Detail unterscheiden.

- Insbesondere ergibt sich bezüglich Korrelationsgerade und Ellipsenhauptachse kein Unterschied zum Parametersatz $(1)$.

Aufgaben zum Kapitel

Aufgabe 4.7: Gewichtete Summe und Differenz

Aufgabe 4.7Z: Erzeugung einer 2D–WDF

Aufgabe 4.8: Rautenförmige 2D-WDF