Contents

Zufallsprozesse (1)

Ein wichtiger Begriff der stochastischen Signaltheorie ist der Zufallsprozess. Nachfolgend sind einige Charakteristika eines solchen stochastischen Prozesses – diese Bezeichnungen werden sowohl in der Literatur als auch in unserem Tutorial synonym verwendet – zusammengestellt:

- Unter einem Zufallsprozess { $x_i(t)$} verstehen wir ein mathematisches Modell für ein Ensemble von (vielen) Zufallssignalen, die sich zwar im Detail durchaus voneinander unterscheiden können, trotzdem aber gewisse gemeinsame Eigenschaften aufweisen.

- Zur Beschreibung eines Zufallsprozesses { $x_i(t)$} gehen wir von der Vorstellung aus, dass beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Zufallsgeneratoren vorhanden sind, von denen jeder ein Zufallssignal $x_i(t)$ liefert.

- Jeder Zufallsgenerator gibt trotz gleicher physikalischer Realisierung ein anderes Zeitsignal $x_i(t)$ ab, das für alle Zeiten von $–∞$ bis $+∞$ existiert. Man bezeichnet dieses spezifische Zufallssignal als das $i$-te Mustersignal.

- Jeder Zufallsprozess beinhaltet mindestens eine stochastische Komponente – zum Beispiel die Amplitude, Frequenz oder Phase eines Nachrichtensignals – und kann daher von einem Beobachter nicht exakt vorausgesagt werden.

- Der Zufallsprozess unterscheidet sich von den sonst in der Wahrscheinlichkeitsrechnung bzw. der Statistik üblichen Zufallsexperimenten dadurch, dass das Ergebnis kein Ereignis ist, sondern ein Funktionsverlauf (Zeitsignal).

- Betrachtet man den Zufallsprozess { $x_i(t)$} zu einem festen Zeitpunkt, so gelangt man wieder zu dem einfacheren Modell von Kapitel 2.1, nach dem das Versuchsergebnis ein Ereignis ist, das einer Zufallsgröße zugeordnet werden kann.

Zufallsprozesse (2)

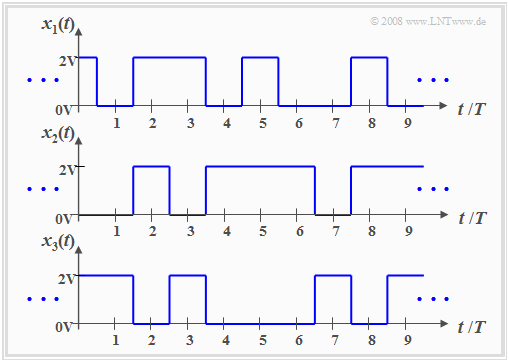

Die Aussagen der vorherigen Seite werden nun am Beispiel eines binären Zufallsgenerators verdeutlicht, der – zumindest gedanklich – beliebig oft realisiert werden kann.

Die Grafik zeigt drei unterschiedliche Mustersignale mit folgenden Eigenschaften:

- Der hier vorliegende Zufallsprozess { $x_i(t)$} besteht aus einem Ensemble rechteckförmiger Musterfunktionen, die jeweils wie folgt beschrieben werden können:

$$x_i(t)=\sum^{+\infty}_{\nu=-\infty} (a_\nu)_i\cdot g(t-\nu \cdot T ).$$

- Der Grundimpuls $g(t)$ besitzt im Bereich von $–T/2$ bis $+T/2$ den Wert 2V; außerhalb ist er 0. Unter einem Impuls verstehen wir gemäß der Definition im Buch „Signaldarstellung” ein sowohl deterministisches als auch energiebegrenztes Signal.

- Die Statistik des hier betrachteten Zufallsprozesses ist aomit allein auf die dimensionslosen Amplitudenkoeffizienten $(a_ν)_i ∈$ {0, 1} zurückzuführen, die bei der $i$-ten Musterfunktion mit dem Zeitindex $ν$ versehen sind.

- Trotz der im Detail unterschiedlichen Signalverläufe weisen die skizzierten Mustersignale $x_1(t), x_2(t) , x_3(t)$ und auch alle weiteren Mustersignale $x_4(t), x_5(t), x_6(t),$ ... gewisse Gemeinsamkeiten auf, die nachfolgend herausgearbeitet werden sollen.

Stationäre Zufallsprozesse

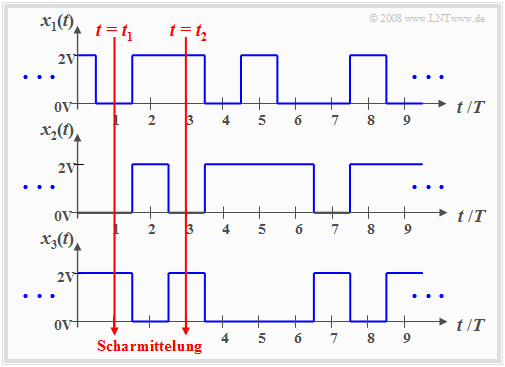

Definiert man den Momentanwert aller Musterfunktionen $x_i(t)$ zu einem festen Zeitpunkt $t = t_1$ als eine neue Zufallsgröße $x_1 =$ { $x_i(t_1)$}, so lassen sich deren statistische Eigenschaften nach den Aussagen von Kapitel 2 und Kapitel 3 beschreiben. In gleicher Weise erhalten wir für den Betrachtungszeitpunkt $t = t_2$ die Zufallsgröße $x_2 =$ { $x_i(t_2)$}.

Hinweis: Beachten Sie bitte, dass $x_1(t)$ und $x_2(t)$ Musterfunktionen des Zufallsprozesses { $x_i(t)$} sind, während die Zufallsgrößen $x_1$ und $x_2$ den Prozess zu den Zeiten $t_1$ und $t_2$ charakterisieren.

Die Berechnung der statistischen Kenngrößen muss durch Scharmittelung über alle möglichen Musterfunktionen erfolgen (Mittelung über die Laufvariable $i$, also über alle Realisierungen).

Bei einem stationären Zufallsprozess { $x_i(t)$} sind alle statistischen Kenngrößen der Zufallsgrößen $x_1$ und $x_2$ gleich. Auch zu jedem anderen Zeitpunkt ergeben sich genau gleiche Werte.

Die Umkehrung lautet: Man bezeichnet einen Zufallsprozess { $x_i(t)$} als nichtstationär, wenn er zu verschiedenen Zeitpunkten unterschiedliche statistische Eigenschaften (Mittelwert, Streuung, Momente höherer Ordnung, Auftrittswahrscheinlichkeiten, etc.) aufweist.

Eine große Anzahl von Mess-Stationen am Äquator ermitteln täglich um 12 Uhr Ortszeit die Temperatur. Mittelt man über all diese Messwerte, so kann man den Einfluss lokaler Indikatoren (z. B. Golfstrom) eliminieren. Trägt man die Mittelwerte (Scharmittelung) über der Zeit auf, so wird sich nahezu eine Konstante ergeben, und man kann von einem stationären Prozess sprechen.

Eine vergleichbare Messreihe am 50. Breitengrad würde aufgrund der jahreszeitlichen Schwankungen auf einen nichtstationären Prozess hinweisen mit deutlichen Unterschieden hinsichtlich Mittelwert und Varianz der Mittagstemperatur zwischen Januar und Juli.

Ergodische Zufallsprozesse

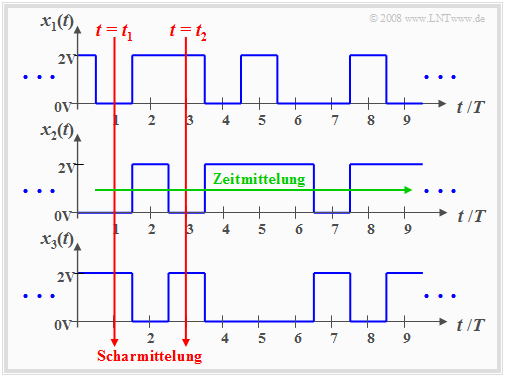

Eine wichtige Unterklasse der stationären Zufallsprozesse sind die so genannten ergodischen Prozesse mit folgenden Eigenschaften:

- Bei einem ergodischen Prozess { $x_i(t)$} ist jede einzelne Musterfunktion $x_i(t)$ repräsentativ für das gesamte Ensemble.

- Alle statistischen Beschreibungsgrößen eines ergodischen Prozesses kann man aus einer einzigen Musterfunktion durch Zeitmittelung (bezüglich der Laufvariablen $ν$) gewinnen.

- Das bedeutet auch: Bei Ergodizität stimmen die Zeitmittelwerte einer jeden Musterfunktion mit den entsprechenden Scharmittelwerten zu beliebigen Zeitpunkten überein.

- Beispielsweise gilt bei Ergodizität für das Moment $k$-ter Ordnung:

$$m_k=\overline{x^k(t)}={\rm E}[x^k].$$

Die überstreichende Linie kennzeichnet hierbei den Zeitmittelwert, während der Scharmittelwert durch Erwartungswertswertbildung E[ ... ] zu ermitteln ist, wie in Kapitel 2.2 beschrieben.

Anmerkung: Die Ergodizität lässt sich aus einer endlichen Anzahl von Musterfunktionen und endlichen Signalausschnitten nicht nachweisen. Allerdings wird in den meisten Anwendungen zwar hypothetisch – aber trotzdem durchaus berechtigt – von Ergodizität ausgegangen. Anhand der gefundenen Ergebnisse muss anschließend die Plausibilität dieser Ergodizitätshypothese überprüft werden.

Allgemeingültige Beschreibung von Zufallsprozessen

Ist der zu analysierende Zufallsprozess { $x_i(t)$} nicht stationär und damit mit Sicherheit auch nicht ergodisch, so müssen die Momente stets als Scharmittelwerte bestimmt werden. Im Allgemeinen sind diese zeitabhängig: $$m_k(t_1) \ne m_k(t_2).$$ Da durch die Momente aber auch die charakteristische Funktion (Fourierrücktransformierte der WDF) $$ C_x(\Omega) ={\rm\sum^{\infty}_{{\it k}=0}}\frac{m_k}{k!}\cdot \Omega^{k}\circ\!\!-\!\!\!-\!\!\!-\!\!\bullet\,f_{\rm x}(x)$$ festliegt, ist die Wahrscheinlichkeitsdichtefunktion $f_{\rm x}(x)$ ebenfalls zeitabhängig.

Sollen nun nicht nur die Amplitudenverteilungen zu den verschiedenen Zeitpunkten $t_1, t_2,$ ... ermittelt werden, sondern auch die statistischen Bindungen zwischen den Signalwerten zu diesen Zeiten, so muss man auf die zweidimensionale Verbundwahrscheinlichkeitsdichtefunktion übergehen.

Betrachtet man beispielsweise die beiden Zeitpunkte $t_1$ und $t_2$, so ist folgendes zu vermerken:

- Die 2D-WDF ergibt sich entsprechend den Angaben in Kapitel 4.1 mit $x = x(t_1)$ und $y = x(t_2)$. Es ist offensichtlich, dass bereits die Ermittlung dieser Größe sehr aufwändig ist.

- Berücksichtigt man weiter, dass zur Erfassung aller statistischen Bindungen innerhalb des Zufallsprozesses eigentlich die $n$-dimensionale Verbundwahrscheinlichkeitsdichtefunktion (VWDF) herangezogen werden müsste, wobei möglichst noch der Grenzwert $n → ∞$ zu bilden ist, so erkennt man die Schwierigkeiten für die Lösung praktischer Probleme.

- Aus diesen Gründen geht man zur Beschreibung der statistischen Bindungen eines Zufallsprozesses auf die Autokorrelationsfunktion über, die nachfolgend definiert wird.