- [[Linear and Time Invariant Systems/{{{Vorherige Seite}}} | Previous page]]

- [[Linear and Time Invariant Systems/{{{Vorherige Seite}}} | Previous page]]

Contents

- 1 # OVERVIEW OF THE FIRST MAIN CHAPTER #

- 2 Das Ursachen-Wirkungs-Prinzip

- 3 Anwendung in der Nachrichtentechnik

- 4 Voraussetzungen für die Anwendung der Systemtheorie

- 5 Transfer function – Frequency response

- 6 Eigenschaften des Frequenzgangs

- 7 Tiefpass, Hochpass, Bandpass und Bandsperre

- 8 Testsignale zur Messung des Frequenzgangs

- 9 Aufgaben zum Kapitel

# OVERVIEW OF THE FIRST MAIN CHAPTER #

In the book "Signal Representation" you were familiarised with the mathematical description of deterministic signals in the time and frequency domain. The second book "Linear Time-Variant Systems" now describes which changes a signal or its spectrum undergoes through an information system and how these changes can be captured mathematically.

$\text{Please note:}$

- The "system" can be a simple circuit as well as a complete, highly complicated transmission system with a multitude of components.

- It is only assumed here that the system has the two properties ”linear” and ”time-invariant”.

In the first chapter, the basics of the so-called systems theory are mentioned, which allows a uniform and simple description of such systems. We start with the system description in the frequency domain with the partial aspects listed above.

Further information on the topic as well as tasks, simulations and programming exercises can be found in

- Chapter 6: Linear Time-Invariant Systems (Programme lzi)

of the practical course "Simulation Methods in Communications Engineering". This (former) LNT course at the TU Munich is based on

- the educational software package, and

- this practical course guide.

Das Ursachen-Wirkungs-Prinzip

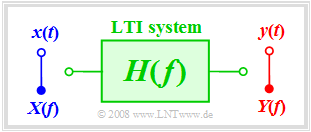

Wir betrachten in diesem Kapitel stets das rechts skizzierte einfache Modell.

Diese Anordnung ist wie folgt zu interpretieren:

- Im Mittelpunkt steht das so genannte System, das in seiner Funktion weitestgehend abstrahiert ist („Black Box”). Über die Realisierung des Systems ist nichts Genaues bekannt.

- Die auf dieses System einwirkende zeitabhängige Eingangsgröße $x(t)$ bezeichnen wir im Folgenden auch als die Ursachenfunktion.

- Am Ausgang des Systems erscheint dann die Wirkungsfunktion $y(t)$ – quasi als Antwort des Systems auf die Eingangsfunktion $x(t)$.

Anmerkung: Das System kann im Allgemeinen von beliebiger Art sein und ist nicht allein auf die Nachrichtentechnik beschränkt. Vielmehr wird auch in anderen Wissenschaftsgebieten wie zum Beispiel den Naturwissenschaften, der Volks- und Betriebswirtschaft, der Soziologie und der Politologie versucht, Kausalzusammenhänge zwischen verschiedenen Größen durch das Ursachen–Wirkungs–Prinzip zu erfassen und zu beschreiben.

Die für diese phänomenologischen Systemtheorien angewandten Methoden unterscheiden sich aber deutlich von der Vorgehensweise in der Nachrichtentechnik, die in diesem ersten Hauptkapitel des vorliegenden Buches „Lineare zeitinvariante Systeme” dargelegt wird.

Anwendung in der Nachrichtentechnik

Das Ursachen–Wirkungs–Prinzip lässt sich auch in der Nachrichtentechnik anwenden, beispielsweise zur Beschreibung von Zweipolen. Hier kann man den Stromverlauf $i(t)$ als Ursachenfunktion und die Spannung $u(t)$ als Wirkungsfunktion betrachten. Durch Beobachten der I/U–Beziehungen lassen sich so Rückschlüsse über die Eigenschaften des eigentlich unbekannten Zweipols ziehen.

Karl Küpfmüller hat den Begriff „Systemtheorie” 1949 erstmals (in Deutschland) eingeführt. Er versteht darunter eine Methode zur Beschreibung komplexer Kausalzusammenhänge in Naturwissenschaften und Technik, basierend auf einer Spektraltransformation – beispielsweise der im Buch „Signaldarstellung” dargelegten Fouriertransformation.

Man kann ein ganzes Nachrichtensystem systemtheoretisch beschreiben. Hier ist

- die Ursachenfunktion das Eingangssignal $x(t)$ bzw. dessen Spektrum $X(f)$,

- die Wirkungsfunktion das Ausgangssignal $y(t)$ oder das Spektrum $Y(f)$.

Auch in den folgenden Bildern werden die Eingangsgrößen meist blau, die Ausgangsgrößen rot und Systemgrößen grün gezeichnet.

$\text{Beispiel 1:}$ Beschreibt das „Nachrichtensystem” eine vorgegebene lineare Schaltung, so kann bei bekanntem Eingangssignal $x(t)$ mit Hilfe der Systemtheorie das Ausgangssignal $y(t)$ vorhergesagt werden. Eine zweite Aufgabe der Systemtheorie besteht darin, durch Messung von $y(t)$ bei Kenntnis von $x(t)$ das Nachrichtensystem zu klassifizieren, ohne dieses im Detail zu kennen.

Beschreibt $x(t)$ beispielsweise die Stimme eines Anrufers aus Hamburg und $y(t)$ die Aufzeichnung eines Anrufbeantworters in München, dann besteht das „Nachrichtensystem” aus folgenden Komponenten:

Mikrofon – Telefon – elektrische Leitung – Signalumsetzer – Glasfaserkabel – optischer Verstärker – Signalrücksetzer – Empfangsfilter (zum Beispiel zur Entzerrung und Rauschbegrenzung) – ... – elektromagnetischer Wandler.

Voraussetzungen für die Anwendung der Systemtheorie

Das oben angegebene Modell eines Nachrichtensystems gilt allgemein und unabhängig von den Randbedingungen. Die Anwendung der Systemtheorie erfordert jedoch zusätzlich einige einschränkende Voraussetzungen.

Wenn nicht explizit etwas anderes angegeben ist, soll für das Folgende stets gelten:

- Sowohl $x(t)$ als auch $y(t)$ sind deterministische Signale. Andernfalls muss man entsprechend der Seite Stochastische Systemtheorie im Buch „Stochastische Signaltheorie” vorgehen.

- Das System ist linear. Dies erkennt man zum Beispiel daran, dass eine harmonische Schwingung $x(t)$ am Eingang auch eine harmonische Schwingung $y(t)$ gleicher Frequenz am Ausgang zur Folge hat:

- $$x(t) = A_x \cdot \cos(\omega_0 \hspace{0.05cm}t - \varphi_x)\hspace{0.2cm}\Rightarrow \hspace{0.2cm} y(t) = A_y \cdot\cos(\omega_0 \hspace{0.05cm}t - \varphi_y).$$

- Neue Frequenzen entstehen nicht. Lediglich Amplitude und Phase der harmonischen Schwingung können verändert werden. Nichtlineare Systeme werden im Kapitel Nichtlineare Verzerrungen behandelt.

- Aufgrund der Linearität ist auch das Superpositionsprinzip anwendbar. Dieses besagt, dass aus $x_1(t) ⇒ y_1(t)$ und $x_2(t) ⇒ y_2(t)$ auch zwingend die folgende Zuordnung gilt:

- $$x_1(t) + x_2(t) \hspace{0.1cm}\Rightarrow \hspace{0.1cm} y_1(t) + y_2(t).$$

- Das System ist zeitinvariant. Das bedeutet, dass ein um $\tau$ verschobenes Eingangssignal das gleiche Ausgangssignal zur Folge hat – dieses aber ebenfalls um $\tau$ verzögert ist:

- $$x(t - \tau) \hspace{0.1cm}\Rightarrow \hspace{0.1cm} y(t -\tau)\hspace{0.4cm}{\rm falls} \hspace{0.4cm}x(t )\hspace{0.2cm}\Rightarrow \hspace{0.1cm} y(t).$$

- Zeitvariante Systeme werden im Buch Mobile Kommunikation behandelt.

Sind alle hier aufgeführten Voraussetzungen erfüllt, so spricht man von einem linearen zeitinvarianten System, abgekürzt LZI–System. In der englischsprachigen Literatur ist hierfür die Abkürzung LTI (Linear Time–invariant) gebräuchlich.

Transfer function – Frequency response

Wir setzen ein LZI–System voraus, dessen Eingangs– und Ausgangsspektren $X(f)$ und $Y(f)$ bekannt sind oder aus den Zeitsignalen $x(t)$ und $y(t)$ durch Fouriertransformation berechnet werden können.

$\text{Definition:}$ Das Übertragungsverhalten eines Nachrichtensystems wird im Frequenzbereich durch die Übertragungsfunktion beschrieben:

- $$H(f) = \frac{Y(f)}{X(f)}= \frac{ {\rm Wirkungsfunktion} }{ {\rm Ursachenfunktion} }.$$

Weitere Bezeichnungen für $H(f)$ sind „Systemfunktion” und „Frequenzgang”. Im Folgenden werden wir vorwiegend den letzten Begriff verwenden.

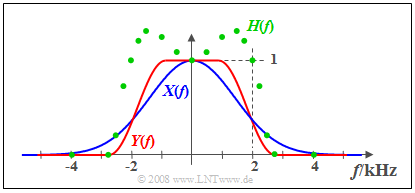

$\text{Beispiel 2:}$ Am Eingang eines LZI–Systems liegt das Signal $x(t)$ mit dem reellen Spektrum $X(f)$ an (blaue Kurve). Das gemessene Ausgangsspektrum $Y(f)$ – in der Grafik rot markiert – ist bei Frequenzen kleiner als $2 \ \rm kHz$ größer als $X(f)$ und besitzt im Bereich um $2 \ \rm kHz$ eine steilere Flanke. Oberhalb von $2.8 \ \rm kHz$ hat das Signal $y(t)$ keine Spektralanteile.

- Die grünen Kreise markieren einige Messpunkte des ebenfalls reellen Frequenzgangs

- $$H(f) = Y(f)/X(f).$$

- Bei niedrigen Frequenzen ist $H(f)>1$: In diesem Bereich wirkt das LZI–System verstärkend.

- Der Flankenabfall von $H(f)$ verläuft ähnlich wie der von $Y(f)$, ist aber nicht identisch.

Eigenschaften des Frequenzgangs

Der Frequenzgang $H(f)$ ist eine zentrale Größe bei der Beschreibung nachrichtentechnischer Systeme.

Nachfolgend werden einige Eigenschaften dieser wichtigen Systemgröße aufgezählt:

- Der Frequenzgang beschreibt allein das LZI–System. Er ist zum Beispiel aus den linearen Bauelementen eines elektrischen Netzwerks berechenbar. Bei anderem Eingangssignal $x(t)$ und dementsprechend anderem Ausgangssignal $y(t)$ ergibt sich der genau gleiche Frequenzgang $H(f)$.

- $H(f)$ kann eine „Einheit” besitzen. Betrachtet man zum Beispiel bei einem Zweipol den Spannungsverlauf $u(t)$ als Ursache und den Strom $i(t)$ als Wirkung, so hat der Frequenzgang $H(f) = I(f)/U(f)$ die Einheit $\rm A/V$. $I(f)$ und $U(f)$ sind die Fouriertransformierten von $i(t)$ bzw. $u(t)$.

- Im Folgenden betrachten wir ausschließlich Vierpole. Zudem setzen wir ohne Einschränkung der Allgemeingültigkeit meist voraus, dass $x(t)$ und $y(t)$ jeweils Spannungen seien. In diesem Fall ist $H(f)$ stets dimensionslos.

- Da die Spektren $X(f)$ und $Y(f)$ im allgemeinen komplex sind, ist auch der Frequenzgang $H(f)$ eine komplexe Funktion. Man nennt den Betrag $|H(f)|$ den Amplitudengang. Dieser wird auch oft in logarithmierter Form dargestellt und als Dämpfungsverlauf bezeichnet:

- $$a(f) = - \ln |H(f)| = - 20 \cdot \lg |H(f)|.$$

- Je nachdem, ob die erste Form mit dem natürlichen oder die zweite mit dekadischem Logarithmus verwendet wird, ist die Pseudoeinheit „Neper” (Np) bzw. „Dezibel” (dB) hinzuzufügen.

- Der Phasengang ist aus $H(f)$ in folgender Weise berechenbar:

- $$b(f) = - {\rm arc} \hspace{0.1cm}H(f) \hspace{0.2cm}{\rm in\hspace{0.1cm}Radian \hspace{0.1cm}(rad)}.$$

Damit kann der gesamte Frequenzgang auch wie folgt dargestellt werden:

- $$H(f) = \vert H(f)\vert \cdot {\rm e}^{ - {\rm j} \hspace{0.05cm} \cdot\hspace{0.05cm} b(f)} = {\rm e}^{-a(f)}\cdot {\rm e}^{ - {\rm j}\hspace{0.05cm} \cdot \hspace{0.05cm} b(f)}.$$

Tiefpass, Hochpass, Bandpass und Bandsperre

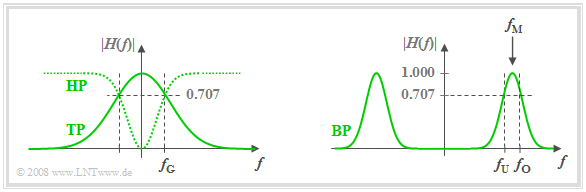

Nach dem Amplitudengang $|H(f)|$ unterscheidet man zwischen

- Tiefpass: Signalanteile werden mit zunehmender Frequenz in der Tendenz stärker gedämpft.

- Hochpass: Hier werden hochfrequente Signalanteile weniger gedämpft als niederfrequente. Ein Gleichsignal $($also ein Signalanteil mit der Frequenz $f = 0)$ kann über einen Hochpass nicht übertragen werden.

- Bandpass: Es gibt eine bevorzugte Frequenz, die man als Mittenfrequenz $f_{\rm M}$ bezeichnet. Je weiter die Frequenz eines Signalanteils von $f_{\rm M}$ entfernt ist, um so stärker wird dieser gedämpft.

- Bandsperre: Dies ist das Gegenstück zum Bandpass und es gilt $|H(f_{\rm M})| ≈ 0$. Sehr niederfrequente und sehr hochfrequente Signalanteile werden dagegen gut durchgelassen.

Die Grafik zeigt die Amplitudengänge der Filtertypen „Tiefpass” (TP) und „Hochpass” (HP) (links) sowie „Bandpass” (BP) (rechts).

- Ebenfalls eingezeichnet sind die Grenzfrequenzen $f_{\rm G}$ (bei Tiefpass und Hochpass) bzw. $f_{\rm U}$ und $f_{\rm O}$ (beim Bandpass).

- Diese bezeichnen hier 3dB–Grenzfrequenzen, zum Beispiel gemäß der folgenden Definition.

$\text{Definition:}$ Die 3dB–Grenzfrequenz eines Tiefpasses gibt diejenige Frequenz $f_{\rm G}$ an, für die gilt:

- $$\vert H(f = f_{\rm G})\vert = {1}/{\sqrt{2} } \cdot \vert H(f = 0)\vert \hspace{0.5cm}\Rightarrow\hspace{0.5cm} \vert H(f = f_{\rm G})\vert^2 = {1}/{2} \cdot \vert H(f = 0) \vert^2.$$

- Anzumerken ist, dass es für die Grenzfrequenz auch eine Reihe anderer Definitionen gibt.

- Diese finden Sie auf der Seite Allgemeine Bemerkungen im Kapitel „Einige systemtheoretische Tiefpassfunktionen” .

Testsignale zur Messung des Frequenzgangs

Zur messtechnischen Erfassung des Frequenzgangs $H(f)$ eignet sich jedes beliebige Eingangssignal $x(t)$ mit Spektrum $X(f)$, solange $X(f)$ keine Nullstelle (im interessierenden Bereich) aufweist. Durch Messung des Ausgangsspektrums $Y(f)$ lässt sich so der Frequenzgang in einfacher Weise ermitteln:

- $$H(f) = \frac{Y(f)}{X(f)}.$$

Insbesondere sind folgende Eingangssignale geeignet:

- Diracimpuls $x(t) = K · δ(t)$ ⇒ Spektrum $X(f) = K$:

- Somit ist der Frequenzgang nach Betrag und Phase formgleich mit dem Ausgangsspektrum $Y(f)$ und es gilt $H(f) = 1/K · Y(f)$. Approximiert man den Diracimpuls durch ein schmales Rechteck gleicher Fläche $K$, so muss $H(f)$ mit Hilfe einer ${\rm sin}(x)/x$–Funktion korrigiert werden.

- Diracpuls – die unendliche Summe gleichgewichteter Diracimpulse im zeitlichen Abstand $T_{\rm A}$:

- Dieser führt gemäß dem Kapitel Zeitdiskrete Signaldarstellung im Buch „Signaldarstellung” zu einem Diracpuls im Frequenzbereich mit Abstand $f_{\rm A} =1/T_{\rm A}$. Damit ist eine frequenzdiskrete Messung von $H(f)$ möglich, mit den spektralen Abtastwerten im Abstand $f_{\rm A}$.

- Harmonische Schwingung $x(t) = A_x · \cos (2πf_0t - φ_x)$ ⇒ diracförmiges Spektrum bei $\pm f_0$:

- Das Ausgangssignal $y(t) = A_y · \cos(2πf_0t - φ_y)$ ist eine Schwingung mit gleicher Frequenz $f_0$. Der Frequenzgang lautet für $f_0 \gt 0$:

- $$H(f_0) = \frac{Y(f_0)}{X(f_0)} = \frac{A_y}{A_x}\cdot{\rm e}^{\hspace{0.05cm} {\rm j} \hspace{0.05cm} \cdot \hspace{0.05cm} (\varphi_x - \varphi_y)}.$$

- Zur Ermittlung des gesamten Frequenzgangs $H(f)$ sind (unendlich) viele Messungen mit verschiedenen Frequenzen $f_0$ erforderlich.

Aufgaben zum Kapitel

Aufgabe 1.1: Einfache Filterfunktionen

Aufgabe 1.1Z: Tiefpass 1. und 2. Ordnung

Aufgabe 1.2Z: Messung der Übertragungsfunktion