Difference between revisions of "Theory of Stochastic Signals/Two-Dimensional Random Variables"

| Line 35: | Line 35: | ||

==Properties and examples== | ==Properties and examples== | ||

<br> | <br> | ||

| − | As a transition to the [[Theory_of_Stochastic_Signals/Auto-Correlation_Function_(ACF)| | + | As a transition to the [[Theory_of_Stochastic_Signals/Auto-Correlation_Function_(ACF)|correlation functions]] we now consider two random variables $x$ and $y$, between which statistical bindings(???) exist. Each of the two random variables can be described on its own with the introduced characteristic quantities |

*corresponding to the second main chapter ⇒ [[Theory_of_Stochastic_Signals/From_Random_Experiment_to_Random_Variable#.23_OVERVIEW_OF_THE_SECOND_MAIN_CHAPTER_.23|Discrete Random Variables]] | *corresponding to the second main chapter ⇒ [[Theory_of_Stochastic_Signals/From_Random_Experiment_to_Random_Variable#.23_OVERVIEW_OF_THE_SECOND_MAIN_CHAPTER_.23|Discrete Random Variables]] | ||

*but the third main chapter ⇒ [[Theory_of_Stochastic_Signals/Probability_Density_Function#.23_OVERVIEW_OF_THE_THIRD_MAIN_CHAPTER_.23|Continuous Random Variables]]. | *but the third main chapter ⇒ [[Theory_of_Stochastic_Signals/Probability_Density_Function#.23_OVERVIEW_OF_THE_THIRD_MAIN_CHAPTER_.23|Continuous Random Variables]]. | ||

Revision as of 15:08, 13 January 2022

Contents

- 1 # OVERVIEW OF THE FOURTH MAIN CHAPTER #

- 2 Properties and examples

- 3 Joint PDF

- 4 Two-dimensional CDF

- 5 WDF und VTF bei statistisch unabhängigen Komponenten

- 6 WDF und VTF bei statistisch abhängigen Komponenten

- 7 Erwartungswerte zweidimensionaler Zufallsgrößen

- 8 Korrelationskoeffizient

- 9 Korrelationsgerade

- 10 Aufgaben zum Kapitel

# OVERVIEW OF THE FOURTH MAIN CHAPTER #

Now random variables with statistical bindings are treated and illustrated by typical examples. After the general description of two-dimensional random variables, we turn to the autocorrelation function (ACF), the cross correlation function (CCF) and the associated spectral functions (PSD, CPSD) .

Specifically, it covers:

- the statistical description of 2D random variables using the (joint) PDF,

- the difference between statistical dependence and correlation, ???

- the classification features stationarity and ergodicity of stochastic processes,

- the definitions of autocorrelation function (ACF) and power spectral density (PSD),

- the definitions of cross correlation function and cross power spectral density, and

- the numerical determination of all these quantities in the two- and multi-dimensional cases.

For more information on Two-Dimensional Random Variables, as well as tasks, simulations, and programming exercises, see

- Chapter 5: Two-dimensional random variables (program "zwd")

- Chapter 9: Stochastic Processes (program "sto")

of the practical course "Simulation Methods in Communications Engineering". This (former) LNT course at the TU Munich is based on

- the teaching software package LNTsim ⇒ Link refers to the German ZIP–version of the program,

- Internship Guide – Part A ⇒ Link refers to the German PDF–version with chapter 5: pages 81-97,

- the Internship Guide – Part B ⇒ Link refers to the German PDF–version with chapter 9: pages 207-228.

Properties and examples

As a transition to the correlation functions we now consider two random variables $x$ and $y$, between which statistical bindings(???) exist. Each of the two random variables can be described on its own with the introduced characteristic quantities

- corresponding to the second main chapter ⇒ Discrete Random Variables

- but the third main chapter ⇒ Continuous Random Variables.

$\text{Definition:}$ To describe the correlations between two variables $x$ and $y$ it is convenient to combine the two components into one two-dimensional random variable $(x, y)$ }.

- The individual components can be signals such as the real– and imaginary parts of a phase modulated signal.

- But there are a variety of 2D–random variables in other domains as well, as the following example will show

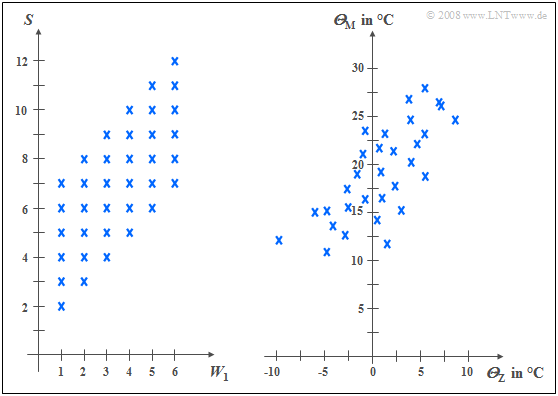

$\text{Example 1:}$ The left diagram is from the random experiment "Throwing two dice". Plotted to the right is the number of the first die $(W_1)$, plotted to the top is the sum $S$ of both dice. The two components here are each discrete random variables between which there are statistical dependencies(???):

- If $W_1 = 1$, then $S$ can only take values between $2$ and $7$ and each with equal probability.

- In contrast, for $W_1 = 6$ all values between $7$ and $12$ are possible, also with equal probability.

In the right graph, the maximum temperatures of the $31$ days in May 2002 of Munich (to the top) and the Zugspitze (to the right) are contrasted. Both random variables are continuous in value:

- although the measurement points are about $\text{100 km}$ apart, and on the Zugspitze, due to the different altitudes $($nearly $3000$ versus $520$ meters$)$ is on average about $20$ degrees colder than in Munich, one recognizes nevertheless a certain statistical dependence between the two random variables ${\it Θ}_{\rm M}$ and ${\it Θ}_{\rm Z}$.

- If it is warm in Munich, then pleasant temperatures are also more likely to be expected on the Zugspitze. However, the relationship is not deterministic: The coldest day in May 2002 was a different day in Munich than the coldest day on the Zugspitze.

Joint PDF

We restrict ourselves here mostly to continuous random variables. However, sometimes the peculiarities of two-dimensional discrete random variables are discussed in more detail. Most of the characteristics previously defined for one-dimensional random variables can be easily extended to two-dimensional variables.

$\text{Definition:}$ The probability density function of the two-dimensional random variable at the location $(x_\mu, y_\mu)$ ⇒ joint PDF' is an extension of the one-dimensional PDF $(∩$ denotes logical AND operation$)$:

- $$f_{xy}(x_\mu, \hspace{0.1cm}y_\mu) = \lim_{\left.{\delta x\rightarrow 0 \atop {\delta y\rightarrow 0} }\right. }\frac{ {\rm Pr}\big [ (x_\mu - {\rm \Delta} x/{\rm 2} \le x \le x_\mu + {\rm \Delta} x/{\rm 2}) \cap (y_\mu - {\rm \Delta} y/{\rm 2} \le y \le y_\mu +{\rm \Delta}y/{\rm 2}) \big] }{ {\rm \delta} \ x\cdot{\rm \Delta} y}.$$

$\rm Note$:

- If the 2D–random variable is discrete, the definition must be slightly modified:

- For the lower range limits in each case, the "≤" sign must then be replaced by the "<" sign according to the page Distribution_Function for discrete random variables

.

Using this (composite) WDF $f_{xy}(x, y)$ statistical dependencies within the two-dimensional random variable $(x, y)$ are also fully captured in contrast to the two one-dimensional density functions ⇒ marginal probability density functions':

- $$f_{x}(x) = \int _{-\infty}^{+\infty} f_{xy}(x,y) \,\,{\rm d}y ,$$

- $$f_{y}(y) = \int_{-\infty}^{+\infty} f_{xy}(x,y) \,\,{\rm d}x .$$

These two marginal density functions $f_x(x)$ and $f_y(y)$

- provide only statistical information about the individual components $x$ and $y$, respectively,

- but not about the bindings between them.

Two-dimensional CDF

$\text{Definition:}$ Die 2D-Verteilungsfunktion ist ebenso wie die 2D-WDF lediglich eine sinnvolle Erweiterung der eindimensionalen Verteilungsfunktion (VTF):

- $$F_{xy}(r_{x},r_{y}) = {\rm Pr}\big [(x \le r_{x}) \cap (y \le r_{y}) \big ] .$$

Es ergeben sich folgende Gemeinsamkeiten und Unterschiede zwischen der 1D-VTF und der 2D-VTF:

- Der Funktionalzusammenhang zwischen zweidimensionaler WDF und zweidimensionaler VTF ist wie im eindimensionalen Fall durch die Integration gegeben, aber nun in zwei Dimensionen. Bei kontinuierlichen Zufallsgrößen gilt:

- $$F_{xy}(r_{x},r_{y})=\int_{-\infty}^{r_{y}} \int_{-\infty}^{r_{x}} f_{xy}(x,y) \,\,{\rm d}x \,\, {\rm d}y .$$

- Umgekehrt lässt sich die Wahrscheinlichkeitsdichtefunktion aus der Verteilungsfunktion durch partielle Differentiation nach $r_{x}$ und $r_{y}$ angeben:

- $$f_{xy}(x,y)=\frac{{\rm d}^{\rm 2} F_{xy}(r_{x},r_{y})}{{\rm d} r_{x} \,\, {\rm d} r_{y}}\Bigg|_{\left.{r_{x}=x \atop {r_{y}=y}}\right.}.$$

- Bezüglich der Verteilungsfunktion $F_{xy}(r_{x}, r_{y})$ gelten folgende Grenzwerte:

- $$F_{xy}(-\infty,-\infty) = 0,$$

- $$F_{xy}(r_{\rm x},+\infty)=F_{x}(r_{x} ),$$

- $$F_{xy}(+\infty,r_{y})=F_{y}(r_{y} ) ,$$

- $$F_{xy} (+\infty,+\infty) = 1.$$

- Im Grenzfall $($unendlich große $r_{x}$ und $r_{y})$ ergibt sich demnach für die 2D-VTF der Wert $1$. Daraus erhält man die Normierungsbedingung für die 2D-WDF:

- $$\int_{-\infty}^{+\infty} \int_{-\infty}^{+\infty} f_{xy}(x,y) \,\,{\rm d}x \,\,{\rm d}y=1 . $$

$\text{Fazit:}$ Beachten Sie den signifikanten Unterschied zwischen eindimensionalen und zweidimensionalen Zufallsgrößen:

- Bei eindimensionalen Zufallsgrößen ergibt die Fläche unter der WDF stets den Wert $1$.

- Bei zweidimensionalen Zufallsgrößen ist das WDF-Volumen immer gleich $1$.

WDF und VTF bei statistisch unabhängigen Komponenten

Bei statistisch unabhängigen Komponenten $x$ und $y$ gilt für die Verbundwahrscheinlichkeit nach den elementaren Gesetzmäßigkeiten der Statistik, falls $x$ und $y$ wertkontinuierlich sind:

- $${\rm Pr} \big[(x_{\rm 1}\le x \le x_{\rm 2}) \cap( y_{\rm 1}\le y\le y_{\rm 2})\big] ={\rm Pr} (x_{\rm 1}\le x \le x_{\rm 2}) \cdot {\rm Pr}(y_{\rm 1}\le y\le y_{\rm 2}) .$$

Hierfür kann bei unabhängigen Komponenten auch geschrieben werden:

- $${\rm Pr} \big[(x_{\rm 1}\le x \le x_{\rm 2}) \cap(y_{\rm 1}\le y\le y_{\rm 2})\big] =\int _{x_{\rm 1}}^{x_{\rm 2}}f_{x}(x) \,{\rm d}x\cdot \int_{y_{\rm 1}}^{y_{\rm 2}} f_{y}(y) \, {\rm d}y.$$

$\text{Definition:}$ Daraus folgt, dass bei statistischer Unabhängigkeit folgende Bedingung bezüglich der 2D–Wahrscheinlichkeitsdichtefunktion erfüllt sein muss:

- $$f_{xy}(x,y)=f_{x}(x) \cdot f_y(y) .$$

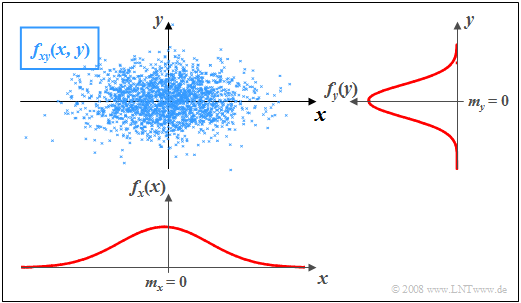

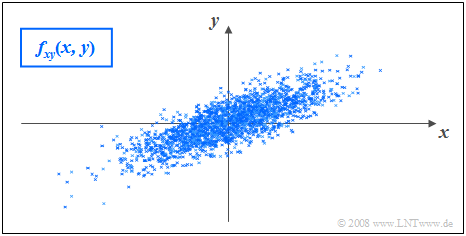

$\text{Beispiel 2:}$ In der Grafik sind die Momentanwerte einer zweidimensionalen Zufallsgröße als Punkte in der $(x, y)$–Ebene eingetragen.

- Bereiche mit vielen Punkten, die dementsprechend dunkel wirken, kennzeichnen große Werte der 2D–WDF $f_{xy}(x, y)$.

- Dagegen besitzt die Zufallsgröße $(x, y)$ in eher hellen Bereichen nur verhältnismäßig wenig Anteile.

Die Grafik kann wie folgt interpretiert werden:

- Die Randwahrscheinlichkeitsdichten $f_{x}(x)$ und $f_{y}(y)$ lassen bereits erkennen, dass sowohl $x$ als auch $y$ gaußähnlich und mittelwertfrei sind, und dass die Zufallsgröße $x$ eine größere Streuung als $y$ aufweist.

- $f_{x}(x)$ und $f_{y}(y)$ liefern jedoch keine Informationen darüber, ob bei der Zufallsgröße $(x, y)$ statistische Bindungen bestehen oder nicht.

- Anhand der 2D-WDF $f_{xy}(x,y)$ erkennt man aber, dass es hier zwischen den beiden Komponenten $x$ und $y$ keine statistischen Bindungen gibt.

- Bei statistischer Unabhängigkeit liefert jeder Schnitt durch $f_{xy}(x, y)$ parallel zur $y$-Achse eine Funktion, die formgleich mit der Rand–WDF $f_{y}(y)$ ist. Ebenso sind alle Schnitte parallel zur $x$-Achse formgleich mit $f_{x}(x)$.

- Diese Tatsache ist gleichbedeutend mit der Aussage, dass in diesem Beispiel $f_{xy}(x, y)$ als Produkt der beiden Randwahrscheinlichkeitsdichten dargestellt werden kann: $f_{xy}(x,y)=f_{x}(x) \cdot f_y(y) .$

WDF und VTF bei statistisch abhängigen Komponenten

Bestehen statistische Bindungen zwischen $x$ und $y$, so liefern unterschiedliche Schnitte parallel zur $x$– bzw. $y$–Achse jeweils unterschiedliche, nicht formgleiche Funktionen. In diesem Fall lässt sich die Verbund–WDF natürlich auch nicht als Produkt der beiden (eindimensionalen) Randwahrscheinlichkeitsdichten beschreiben.

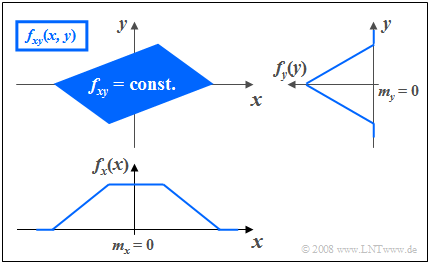

$\text{Beispiel 3:}$ Die Grafik zeigt die Momentanwerte einer zweidimensionalen Zufallsgröße in der $(x, y)$–Ebene, wobei nun im Gegensatz zum $\text{Beispiel 2}$ zwischen $x$ und $y$ statistische Bindungen bestehen.

- Die 2D–Zufallsgröße nimmt im blau eingezeichneten Parallelogramm alle 2D–Werte mit gleicher Wahrscheinlichkeit an.

- Außerhalb des Parallelogramms sind keine Werte möglich.

Man erkennt aus dieser Darstellung:

- Die Integration über $f_{xy}(x, y)$ parallel zur $x$–Achse führt zur dreieckförmigen Randdichte $f_{y}(y)$, die Integration parallel zur $y$–Achse zur trapezförmigen WDF $f_{x}(x)$.

- Aus der 2D-WDF $f_{xy}(x, y)$ ist bereits zu erahnen, dass für jeden $x$–Wert im statistischen Mittel ein anderer $y$–Wert zu erwarten ist.

- Das bedeutet, dass hier die Komponenten $x$ und $y$ statistisch voneinander abhängen.

Erwartungswerte zweidimensionaler Zufallsgrößen

Ein Sonderfall der statistischen Abhängigkeit ist die Korrelation.

$\text{Definition:}$ Unter Korrelation versteht man eine lineare Abhängigkeit zwischen den Einzelkomponenten $x$ und $y$.

- Korrelierte Zufallsgrößen sind damit stets auch statistisch abhängig.

- Aber nicht jede statistische Abhängigkeit bedeutet gleichzeitig eine Korrelation.

Zur quantitativen Erfassung der Korrelation verwendet man verschiedene Erwartungswerte der 2D-Zufallsgröße $(x, y)$.

Diese sind analog definiert zum eindimensionalen Fall

- gemäß Kapitel 2 (bei wertdiskreten Zufallsgrößen)

- bzw. Kapitel 3 (bei wertkontinuierlichen Zufallsgrößen):

$\text{Definition:}$ Für die (nichtzentrierten) Momente gilt die Beziehung:

- $$m_{kl}={\rm E}\big[x^k\cdot y^l\big]=\int_{-\infty}^{+\infty}\hspace{0.2cm}\int_{-\infty}^{+\infty} x\hspace{0.05cm}^{k} \cdot y\hspace{0.05cm}^{l} \cdot f_{xy}(x,y) \, {\rm d}x\, {\rm d}y.$$

Die beiden linearen Mittelwerte sind somit $m_x = m_{10}$ und $m_y = m_{01}.$

$\text{Definition:}$ Die auf $m_x$ bzw. $m_y$ bezogenen Zentralmomente lauten:

- $$\mu_{kl} = {\rm E}\big[(x-m_{x})\hspace{0.05cm}^k \cdot (y-m_{y})\hspace{0.05cm}^l\big] .$$

In dieser allgemein gültigen Definitionsgleichung sind die Varianzen $σ_x^2$ und $σ_y^2$ der zwei Einzelkomponenten durch $\mu_{20}$ bzw. $\mu_{02}$ mit enthalten.

$\text{Definition:}$ Besondere Bedeutung besitzt die Kovarianz $(k = l = 1)$, die ein Maß für die lineare statistische Abhängigkeit zwischen den Zufallsgrößen $x$ und $y$ ist:

- $$\mu_{11} = {\rm E}\big[(x-m_{x})\cdot(y-m_{y})\big] = \int_{-\infty}^{+\infty} \int_{-\infty}^{+\infty} (x-m_{x}) \cdot (y-m_{y})\cdot f_{xy}(x,y) \,{\rm d}x \, {\rm d}y .$$

Im Folgenden bezeichnen wir die Kovarianz $\mu_{11}$ teilweise auch mit $\mu_{xy}$, falls sich die Kovarianz auf die Zufallsgrößen $x$ und $y$ bezieht.

Anmerkungen:

- Die Kovarianz $\mu_{11}=\mu_{xy}$ hängt wie folgt mit dem nichtzentrierten Moment $m_{11} = m_{xy} = {\rm E}\big[x · y\big]$ zusammen:

- $$\mu_{xy} = m_{xy} -m_{x }\cdot m_{y}.$$

- Diese Gleichung ist für numerische Auswertungen enorm vorteilhaft, da $m_{xy}$, $m_x$ und $m_y$ aus den Folgen $〈x_v〉$ und $〈y_v〉$ in einem einzigen Durchlauf gefunden werden können.

- Würde man dagegen die Kovarianz $\mu_{xy}$ entsprechend der oberen Definitionsgleichung berechnen, so müsste man in einem ersten Durchlauf die Mittelwerte $m_x$ und $m_y$ ermitteln und könnte dann erst in einem zweiten Durchlauf den Erwartungswert ${\rm E}\big[(x - m_x) · (y - m_y)\big]$ berechnen.

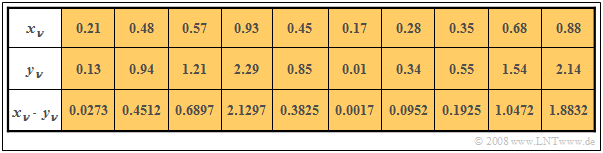

$\text{Beispiel 4:}$ In den beiden ersten Zeilen der Tabelle sind die jeweils ersten Elemente zweier Zufallsfolgen $〈x_ν〉$ und $〈y_ν〉$ eingetragen. In der letzten Zeile sind die jeweiligen Produkte $x_ν · y_ν$ angegeben.

- Durch Mittelung über die jeweils zehn Folgenelemente erhält man

- $$m_x =0.5,\ \ m_y = 1, \ \ m_{xy} = 0.69.$$

- Daraus ergibt sich direkt der Wert für die Kovarianz:

- $$\mu_{xy} = 0.69 - 0.5 · 1 = 0.19.$$

Ohne Kenntnis der Gleichung $\mu_{xy} = m_{xy} - m_x · m_y$ hätte man zunächst im ersten Durchlauf die Mittelwerte $m_x$ und $m_y$ ermitteln müssen,

um dann in einem zweiten Durchlauf die Kovarianz $\mu_{xy}$ als Erwartungswert des Produkts der mittelwertfreien Größen bestimmen zu können.

Korrelationskoeffizient

Bei statististischer Unabhängigkeit der beiden Komponenten $x$ und $y$ ist die Kovarianz $\mu_{xy} \equiv 0$. Dieser Fall wurde bereits im $\text{Beispiel 2}$ auf der Seite WDF und VTF bei statistisch unabhängigen Komponenten betrachtet.

- Das Ergebnis $\mu_{xy} = 0$ ist aber auch bei statistisch abhängigen Komponenten $x$ und $y$ möglich, nämlich dann, wenn diese unkorreliert, also linear unabhängig sind.

- Die statistische Abhängigkeit ist dann nicht von erster, sondern von höherer Ordnung, zum Beispiel entsprechend der Gleichung $y=x^2.$

Man spricht von vollständiger Korrelation, wenn die (deterministische) Abhängigkeit zwischen $x$ und $y$ durch die Gleichung $y = K · x$ ausgedrückt wird. Dann ergibt sich für die Kovarianz:

- $\mu_{xy} = σ_x · σ_y$ bei positivem Wert von $K$,

- $\mu_{xy} = - σ_x · σ_y$ bei negativem $K$–Wert.

Deshalb verwendet man häufig als Beschreibungsgröße anstelle der Kovarianz den so genannten Korrelationskoeffizienten.

$\text{Definition:}$ Der Korrelationskoeffizient ist der Quotient aus der Kovarianz $\mu_{xy}$ und dem Produkt der Effektivwerte $σ_x$ und $σ_y$ der beiden Komponenten:

- $$\rho_{xy}=\frac{\mu_{xy} }{\sigma_x \cdot \sigma_y}.$$

Der Korrelationskoeffizient $\rho_{xy}$ weist folgende Eigenschaften auf:

- Aufgrund der Normierung gilt stets $-1 \le ρ_{xy} ≤ +1$.

- Sind die beiden Zufallsgrößen $x$ und $y$ unkorreliert, so ist $ρ_{xy} = 0$.

- Bei strenger linearer Abhängigkeit zwischen $x$ und $y$ ist $ρ_{xy}= ±1$ ⇒ vollständige Korrelation.

- Ein positiver Korrelationskoeffizient bedeutet, dass bei größerem $x$–Wert im statistischen Mittel auch $y$ größer ist als bei kleinerem $x$.

- Dagegen drückt ein negativer Korrelationskoeffizient aus, dass $y$ mit steigendem $x$ im Mittel kleiner wird.

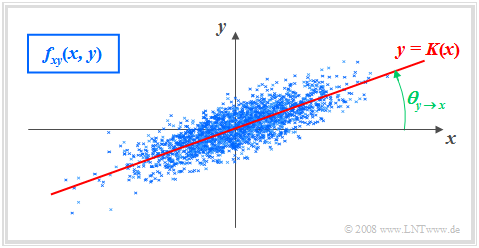

$\text{Beispiel 5:}$ Es gelten folgende Voraussetzungen:

- Die betrachteten Komponenten $x$ und $y$ besitzen jeweils eine gaußförmige WDF.

- Die beiden Streuungen sind unterschiedlich $(σ_y < σ_x)$.

- Der Korrelationskoeffizient beträgt $ρ_{xy} = 0.8$.

Im Unterschied zum Beispiel 2 mit statistisch unabhängigen Komponenten ⇒ $ρ_{xy} = 0$ $($trotz $σ_y < σ_x)$ erkennt man, dass hier bei größerem $x$–Wert im statistischen Mittel auch $y$ größer ist als bei kleinerem $x$.

Korrelationsgerade

$\text{Definition:}$ Als Korrelationsgerade bezeichnet man die Gerade $y = K(x)$ in der $(x, y)$–Ebene durch den „Mittelpunkt” $(m_x, m_y)$. Manchmal wird diese Gerade auch Regressionsgerade genannt.

Die Korrelationsgerade besitzt folgende Eigenschaften:

- Die mittlere quadratische Abweichung von dieser Geraden – in $y$–Richtung betrachtet und über alle $N$ Punkte gemittelt – ist minimal:

- $$\overline{\varepsilon_y^{\rm 2} }=\frac{\rm 1}{N} \cdot \sum_{\nu=\rm 1}^{N}\; \;\big [y_\nu - K(x_{\nu})\big ]^{\rm 2}={\rm Minimum}.$$

- Die Korrelationsgerade kann als eine Art „statistische Symmetrieachse“ interpretiert werden. Die Geradengleichung lautet:

- $$y=K(x)=\frac{\sigma_y}{\sigma_x}\cdot\rho_{xy}\cdot(x - m_x)+m_y.$$

Der Winkel, den die Korrelationsgerade zur $x$–Achse einnimmt, beträgt:

- $$\theta_{y\hspace{0.05cm}\rightarrow \hspace{0.05cm}x}={\rm arctan}\ (\frac{\sigma_{y} }{\sigma_{x} }\cdot \rho_{xy}).$$

Durch diese Nomenklatur soll deutlich gemacht werden, dass es sich hier um die Regression von $y$ auf $x$ handelt.

- Die Regression in Gegenrichtung – also von $x$ auf $y$ – bedeutet dagegen die Minimierung der mittleren quadratischen Abweichung in $x$–Richtung.

- Das interaktive Applet Korrelationskoeffizient und Regressionsgerade verdeutlicht, dass sich im Allgemeinen $($falls $σ_y \ne σ_x)$ für die Regression von $x$ auf $y$ ein anderer Winkel und damit auch eine andere Regressionsgerade ergeben wird:

- $$\theta_{x\hspace{0.05cm}\rightarrow \hspace{0.05cm} y}={\rm arctan}\ (\frac{\sigma_{x}}{\sigma_{y}}\cdot \rho_{xy}).$$

Aufgaben zum Kapitel

Aufgabe 4.1: Dreieckiges (x, y)-Gebiet

Aufgabe 4.1Z: Verabredung zum Frühstück

Aufgabe 4.1: Wieder Dreieckgebiet

Aufgabe 4.2Z: Korrelation zwischen $x$ und $e^x$

Aufgabe 4.3: Algebraische und Modulo-Summe

Aufgabe 4.3Z: Diracförmige 2D-WDF