Exercise 3.5Z: Kullback-Leibler Distance again

Die Wahrscheinlichkeitsfunktion lautet:

$$P_Y(X) = [\hspace{0.03cm}0.25\hspace{0.03cm}, \hspace{0.03cm} 0.25\hspace{0.03cm},\hspace{0.03cm} 0.25 \hspace{0.03cm}, \hspace{0.03cm} 0.25\hspace{0.03cm}]\hspace{0.05cm}$$ Die Zufallsgröße $X$ ist also gekennzeichnet

- durch den Symbolumfang $M=4$,

- mit gleichen Wahrscheinlichkeiten.

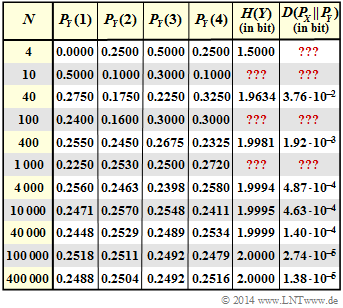

Die Zufallsgröße $Y$ ist stets eine Näherung für $X$. Sie wurde per Simulation aus einer Gleichverteilung gewonnen, wobei jeweils nur $N$ Zufallswerte ausgewertet wurden. Das heißt: $P_Y(1)$,...,$P_Y(4)$ sind im herkömmlichen Sinn keine Wahrscheinlichkeiten. Sie beschreiben vielmehr relative Häufigkeiten.

Das Ergebnis der sechsten Versuchsreihe (mit $N=1000$) ird demnach durch die folgende Wahrscheinlichkeitsfunktion zusammengefasst:

$$P_Y(X) = [\hspace{0.05cm}0.225\hspace{0.05cm}, \hspace{0.05cm} 0.253\hspace{0.05cm},\hspace{0.05cm} 0.250 \hspace{0.05cm}, \hspace{0.05cm} 0.272\hspace{0.05cm}] \hspace{0.05cm}$$ Bei dieser Schreibweise ist bereits berücksichtigt, dass die Zufallsgrößen $X$ und $Y$ auf dem gleichen Alphabet $X =$ {1, 2, 3, 4} basieren.

Mit diesen Voraussetzungen gilt für die relative Entropie (englisch: Informational Divergence) zwischen den Wahrscheinlichkeitsfunktionen $P_X(.)$ und $P_Y(.)$ :

$D( P_X || P_Y) = E_X [ log_2 \frac{P_X(X)}{P_Y(Y)}] = \sum\limits_{\mu=1}^M P_X(\mu) . log_2 \frac{P_X(\mu)}{P_Y(\mu)}$

Man bezeichnet $D( P_X || P_Y)$ als Kullback–Leibler–Distanz. Diese ist ein Maß für die Ähnlichkeit zwischen den beiden Wahrscheinlichkeitsfunktionen $P_X(.)$ und $P_Y(.)$. Die Erwartungswertbildung geschieht hier hinsichtlich der (tatsächlich gleichverteilten) Zufallsgröße $X$. Dies wird durch die Nomenklatur $E_X[.]$ angedeutet.

Eine zweite Form der Kullback–Leibler–Distanz ergibt sich durch die Erwartungswertbildung hinsichtlich der Zufallsgröße $Y \Rightarrow E_Y[.]$:

$D( P_Y || P_X) = E_Y [ log_2 \frac{P_Y(Y)}{P_Y(Y)}] = \sum\limits_{\mu=1}^M P_Y(\mu) . log_2 \frac{P_Y(\mu)}{P_X(\mu)}$

Hinweis: Die Aufgabe bezieht sich auf das Kapitel 3.1 dieses Buches. Die Angaben der Entropie $H(Y)$ und der Kullback–Leibler–Distanz $D( P_X || P_Y)$ in obiger Grafik sind in „bit” zu verstehen. die mit „???" versehenen Felder sollen von Ihnen in dieser Aufgabe ergänzt werden.

Fragebogen

Musterlösung