Contents

Berechnung als Schar- bzw. Zeitmittelwert

Die Wahrscheinlichkeiten bzw. die relativen Häufigkeiten liefern weitreichende Informationen über eine diskrete Zufallsgröße. Reduzierte Informationen erhält man durch die so genannten Momente $m_k$, wobei $k$ eine natürliche Zahl darstellt.

Unter der hier stillschweigend vorausgesetzten Ergodizität gibt es für das Moment $k$-ter Ordnung zwei unterschiedliche Berechnungsmöglichkeiten:

- die Scharmittelung bzw. Erwartungswertbildung (Mittelung über alle möglichen Werte):

- $$m_k = {\rm E} [z^k ] = \sum_{\mu = 1}^{M}p_\mu \cdot z_\mu^k \hspace{2cm} \rm mit \hspace{0.1cm} {\rm E[...]\hspace{-0.1cm}:} \hspace{0.1cm} \rm Erwartungswert ,$$

- die Zeitmittelung über die Zufallsfolge $\langle z_ν\rangle$ mit der Laufvariablen $ν = 1 , \ ... \ , N$:

- $$m_k=\overline{z_\nu^k}=\hspace{0.01cm}\lim_{N\to\infty}\frac{1}{N}\sum_{\nu=\rm 1}^{\it N}z_\nu^k\hspace{1.7cm}\rm mit\hspace{0.1cm}\ddot{u}berstreichender\hspace{0.1cm}Linie\hspace{-0.1cm}:\hspace{0.1cm}Zeitmittelwert.$$

Anzumerken ist:

- Beide Berechnungsarten führen für genügend große Werte von $N$ zum gleichen asymptotischen Ergebnis.

- Bei endlichem $N$ ergibt sich ein vergleichbarer Fehler, als wenn die Wahrscheinlichkeit durch die relative Häufigkeit angenähert wird.

Linearer Mittelwert - Gleichanteil

Mit $k = 1$ erhält man aus der allgemeinen Gleichung für die Momente den linearen Mittelwert: $$m_1 =\sum_{\mu=1}^{M}p_\mu\cdot z_\mu =\lim_{N\to\infty}\frac{1}{N}\sum_{\nu=1}^{N}z_\nu.$$ Der linke Teil dieser Gleichung beschreibt die Scharmittelung (über alle möglichen Werte), während die rechte Gleichung die Bestimmung als Zeitmittelwert angibt. In Zusammenhang mit Signalen wird diese Größe auch als der Gleichanteil bezeichnet.

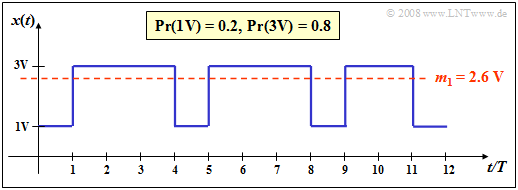

Ein Binärsignal mit den beiden Amplitudenwerten

- $1\hspace{0.03cm}\rm V$ (für das Symbol $\rm L$),

- $3\hspace{0.03cm}\rm V$ (für das Symbol $\rm H$)

sowie den Auftrittswahrscheinlichkeiten $p_{\rm L} = 0.2$ bzw. $p_{\rm H} = 0.8$ besitzt den linearen Mittelwert (Gleichanteil ) $$m_1 = 0.2 \cdot 1\,{\rm V}+ 0.8 \cdot 3\,{\rm V}= 2.6 \,{\rm V}. $$ Dieser ist in der Grafik als rote Linie eingezeichnet.

Bestimmt man diese Kenngröße durch Zeitmittelung über die dargestellten $N = 12$ Signalwerte, so erhält man einen etwas kleineren Wert: $$m_1\hspace{0.05cm}' = 1/3 \cdot 1\,{\rm V}+ 2/3 \cdot 3\,{\rm V}= 2.33 \,{\rm V}. $$ Hier wurden die Auftrittswahrscheinlichkeiten $p_{\rm L} = 0.2$ bzw. $p_{\rm H} = 0.8$ durch die entsprechenden Häufigkeiten $h_{\rm L} = 4/12$ und $h_{\rm H} = 8/12$ ersetzt. Der relative Fehler aufgrund der unzureichenden Folgenlänge $N$ ist im Beispiel größer als $10\%$.

Hinweis zur Nomenklatur: Wir bezeichnen hier Binärsymbole wie in der Schaltungstechnik mit $\rm L$ (Low) und $\rm H$ (High), um Verwechslungen zu vermeiden. In der Codierungstheorie wird sinnvollerweise $\{ \text{L, H}\}$ auf $\{0, 1\}$ abgebildet, um die Möglichkeiten der Modulo-Algebra nutzen zu können. Zur Beschreibung der Modulation mit bipolaren (antipodalen) Signalen wählt man dagegen besser die Zuordnung $\{ \text{L, H}\}$ ⇔ $ \{-1, +1\}$.

Quadratischer Mittelwert – Varianz – Streuung

Analog zum linearen Mittelwert erhält man mit $k = 2$ für den quadratischen Mittelwert: $$m_2 =\sum_{\mu=\rm 1}^{\it M}p_\mu\cdot z_\mu^2 =\lim_{N\to\infty}\frac{\rm 1}{\it N}\sum_{\nu=\rm 1}^{\it N}z_\nu^2.$$

Zusammen mit dem Gleichanteil $m_1$ kann daraus als weitere Kenngröße die Varianz $σ^2$ bestimmt werden (Satz von Steiner): $$\sigma^2=m_2-m_1^2.$$ Als Streuung $σ$ bezeichnet man in der Statistik die Quadratwurzel der Varianz; manchmal wird diese Größe auch Standardabweichung genannt: $$\sigma=\sqrt{m_2-m_1^2}.$$

Hinweise zu den Einheiten:

- Bei Nachrichtensignalen gibt $m_2$ die (mittlere) Leistung eines Zufallssignals an, bezogen auf den Widerstand $1 \hspace{0.03cm} Ω$.

- Beschreibt $z$ eine Spannung, so besitzt $m_2$ die Einheit ${\rm V}^2$.

- Die Varianz $σ^2$ eines Zufallssignals entspricht physikalisch der Wechselleistung und die Streuung $σ$ dem Effektivwert. Dieser Definition liegt wiederum der Bezugswiderstand $1 \hspace{0.03cm} Ω$ zugrunde.

Nachfolgendes Lernvideo verdeutlicht die definierten Größen am Beispiel eines Digitalsignals:

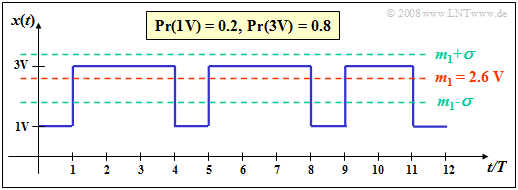

Ein Binärsignal mit den Amplitudenwerten

- $1\hspace{0.05cm}\rm V$ (für das Symbol $\rm L$), und

- $3\hspace{0.05cm}\rm V$ (für das Symbol $\rm H$)

sowie den Auftrittswahrscheinlichkeiten $p_{\rm L} = 0.2$ bzw. $p_{\rm H} = 0.8$ hat eine Signalleistung von $P = 7.4 \hspace{0.05cm}{\rm V}^2$, wenn man vom Bezugswiderstand $R = 1 \hspace{0.05cm} Ω$. ausgeht.

Mit $m_1 = 2.6 \hspace{0.05cm}\rm V$ (siehe vorheriges Beispiel) folgt daraus für

- die Wechselleistung $P_{\rm W} = σ^2 = 0.64\hspace{0.05cm} {\rm V}^2$,

- den Effektivwert $s_{\rm eff} = σ = 0.8 \hspace{0.05cm} \rm V$.

Die gleiche Varianz und der gleiche Effektivwert ergeben sich für die Amplitudenwerte $0\hspace{0.05cm}\rm V$ (für das Symbol $\rm L$) und $2\hspace{0.05cm}\rm V$ (für das Symbol $\rm H$), vorausgesetzt, die Auftrittswahrscheinlichkeiten $p_{\rm L} = 0.2$ und $p_{\rm H} = 0.8$ bleiben gleich.

Bei anderem Bezugswiderstand ⇒ $R \ne 1 \hspace{0.05cm} Ω$ gelten obige Bezeichnungen nur bedingt. Beispielsweise haben mit $R = 50 \hspace{0.05cm} Ω$ die Leistung $P$, die Wechselleistung $P_{\rm W}$ und der Effektivwert $s_{\rm eff}$ folgende Werte: $$P \hspace{-0.05cm}= \hspace{-0.05cm} \frac{m_2}{R} \hspace{-0.05cm}= \hspace{-0.05cm} \frac{7.4\,{\rm V}^2}{50\,{\rm \Omega}} \hspace{-0.05cm}= \hspace{-0.05cm}0.148\,{\rm W},\hspace{0.15cm} P_{\rm W} \hspace{-0.05cm} = \hspace{-0.05cm} \frac{\sigma^2}{R} \hspace{-0.05cm}= \hspace{-0.05cm}12.8\,{\rm mW} \hspace{0.05cm},\hspace{0.15cm} s_{\rm eff} \hspace{-0.05cm} = \hspace{-0.05cm}\sqrt{R \cdot P_{\rm W}} \hspace{-0.05cm}= \hspace{-0.05cm} \sigma \hspace{-0.05cm}= \hspace{-0.05cm} 0.8\,{\rm V}.$$