Contents

Informationsgehalt – Entropie – Redundanz (1)

Wir gehen von einer M–stufigen digitalen Nachrichtenquelle aus, die das Quellensignal

\(q(t) = \sum_{(\nu)} a_\nu \cdot {\rm \delta} ( t - \nu \cdot T)\hspace{0.3cm}{\rm mit}\hspace{0.3cm}a_\nu \in \{ a_1, ... , a_\mu , ... , a_{ M}\}\)

abgibt. Die Quellensymbolfolge 〈qν〉 ist auf die Folge 〈aν〉 der dimensionslosen Amplitudenkoeffizienten abgebildet. Vereinfachend wird zunächst für die Zeitlaufvariable ν = 1, ... , N gesetzt, während der Vorratsindex μ stets Werte zwischen 1 und M annehmen kann.

Ist das ν–te Folgenelement gleich aμ, so kann dessen Informationsgehalt mit der Wahrscheinlichkeit pνμ = Pr(aν = aμ) wie folgt berechnet werden:

\[I_\nu = \log_2 \frac{1}{p_{\nu \mu}}= {\rm ld} \frac{1}{p_{\nu \mu}} \hspace{1cm}{\rm (Einheit: \hspace{0.15cm}bit)}\hspace{0.05cm}.\]

Der Logarithmus zur Basis 2 ⇒ log2 wird oft auch mit „ld(x)” ⇒ Logarithmus dualis bezeichnet. Bei der numerischen Auswertung wird die Hinweiseinheit „bit” hinzugefügt. Mit dem Zehner-Logarithmus lg(x) bzw. dem natürlichen Logarithmus ln(x) gilt:

\[{\rm log_2}(x) = \frac{{\rm lg}(x)}{{\rm lg}(2)}= \frac{{\rm ln}(x)}{{\rm ln}(2)}\hspace{0.05cm}.\]

Nach dieser auf C. E. Shannon zurückgehenden Definition von Information ist der Informationsgehalt eines Symbols umso größer, je kleiner dessen Auftrittswahrscheinlichkeit ist.

\[H = \lim_{N \to \infty} \frac{1}{N} \cdot \sum_{\nu = 1}^N I_\nu =

\lim_{N \to \infty} \frac{1}{N} \cdot \sum_{\nu = 1}^N \hspace{0.1cm}{\rm log_2}\hspace{0.05cm} \frac{1}{p_{\nu \mu}} \hspace{1cm}{\rm (Einheit: \hspace{0.15cm}bit)}\hspace{0.05cm}.\]

Natürlich kann die Entropie auch durch Scharmittelung berechnet werden.

Sind die Folgenelemente aν statistisch voneinander unabhängig, so sind die Auftrittswahrscheinlichkeiten pνμ = pμ unabhängig von ν und man erhält in diesem Sonderfall für die Entropie:

\[H = \sum_{\mu = 1}^M p_{ \mu} \cdot {\rm log_2}\hspace{0.1cm} \frac{1}{p_{ \mu}}\hspace{0.05cm}.\]

Bestehen dagegen statistische Bindungen zwischen benachbarten Amplitudenkoeffizienten aν, so muss zur Entropieberechnung die kompliziertere Definitionsgleichung herangezogen werden.

Informationsgehalt – Entropie – Redundanz (2)

Der Maximalwert der Entropie ergibt sich immer dann, wenn die M Auftrittswahrscheinlichkeiten (der statistisch unabhängigen Symbole) alle gleich sind (pμ = 1/M):

\(H_{\rm max} = \sum_{\mu = 1}^M \hspace{0.1cm}\frac{1}{M} \cdot {\rm log_2} (M) = {\rm log_2} (M) \cdot \sum_{\mu = 1}^M \hspace{0.1cm} \frac{1}{M} = {\rm log_2} (M)

\hspace{1cm}{\rm (Einheit: \hspace{0.15cm}bit)}\hspace{0.05cm}.\)

Man bezeichnet Hmax als den Entscheidungsgehalt (bzw. als Nachrichtengehalt) und den Quotienten

\(r = \frac{H_{\rm max}-H}{H_{\rm max}}\)

als dierelative Redundanz. Da stets 0 ≤ H ≤ Hmax gilt, kann die relative Redundanz Werte zwischen 0 und 1 (einschließlich dieser Grenzwerte) annehmen.

Aus der Herleitung dieser Beschreibungsgrößen ist offensichtlich, dass ein redundanzfreies Digitalsignal (r = 0) folgende Eigenschaften erfüllen muss:

- Die Amplitudenkoeffizienten aν sind statistisch unabhängig; Pr(aν = aμ) ist für alle ν identisch.

- Die M möglichen Koeffizienten aμ treten mit gleicher Wahrscheinlichkeit pμ = 1/M auf.

- der unterschiedlichen Häufigkeiten (beispielsweise tritt „e” deutlich häufiger auf als „u”) und

- von statistischen Bindungen (zum Beispiel folgt auf „q” der Buchstabe „u” viel öfters als „e”)

beträgt nach Karl Küpfmüller die Entropie der deutschen Sprache nur H = 1.3 bit/Zeichen. Daraus ergibt sich die relative Redundanz zu r ≈ (5 – 1.3)/5 = 74%. Für englische Texte wurde von Claude E. Shannon die Entropie mit H = 1 bit/Zeichen angegeben (r = 80%).

Quellen–, Kanal– und Übertragungscodierung

Unter Codierung versteht man die Umsetzung der Quellensymbolfolge 〈qν〉 mit Symbolumfang Mq in eine Codesymbolfolge 〈cν〉 mit dem Symbolumfang Mc. Meist wird durch die Codierung die in einem Digitalsignal enthaltene Redundanz manipuliert. Oft – aber nicht immer – sind Mq und Mc verschieden.

Man unterscheidet je nach Zielrichtung zwischen verschiedenen Arten von Codierung:

- Die Aufgabe der Quellencodierung ist die Redundanzreduktion zur Datenkomprimierung, wie sie beispielsweise in der Bildcodierung Anwendung findet. Durch Ausnutzung statistischer Bindungen zwischen den einzelnen Punkten eines Bildes bzw. zwischen den Helligkeitswerten eines Punktes zu verschiedenen Zeiten (bei Bewegtbildsequenzen) können Verfahren entwickelt werden, die bei nahezu gleicher Bildqualität zu einer merklichen Verminderung der Datenmenge (gemessen in bit oder byte) führen. Ein einfaches Beispiel hierfür ist die differentielle Pulscodemodulation (DPCM).

- Bei der Kanalcodierung erzielt man demgegenüber dadurch eine merkliche Verbesserung des Übertragungsverhaltens, dass eine beim Sender gezielt hinzugefügte Redundanz empfangsseitig zur Erkennung und Korrektur von Übertragungsfehlern genutzt wird. Solche Codes, deren wichtigste Vertreter Block–, Faltungs– und Turbo-Codes sind, haben besonders bei stark gestörten Kanälen eine große Bedeutung. Je größer die relative Redundanz des codierten Signals ist, desto besser sind die Korrektureigenschaften des Codes, allerdings bei verringerter Nutzdatenrate.

- Eine Übertragungscodierung – häufig auch als Leitungscodierung bezeichnet – verwendet man, um das Sendesignal durch eine Umcodierung der Quellensymbole an die spektralen Eigenschaften von Übertragungskanal und Empfangseinrichtungen anzupassen. Beispielsweise muss bei einem Kanal mit der Frequenzgangseigenschaft HK(f = 0) = 0, über den kein Gleichsignal übertragen werden kann, durch Übertragungscodierung sichergestellt werden, dass die Codesymbolfolge weder eine lange L– noch eine lange H–Folge beinhaltet.

Im vorliegenden Buch „Digitalsignalübertragung” beschäftigen wir uns ausschließlich mit diesem letzten, übertragungstechnischen Aspekt. Der Kanalcodierung ist in LNTwww ein eigenes Buch gewidmet (siehe Bücherregalseite), während die Quellencodierung im Buch „Informationstheorie” ausführlich behandelt wird. Auch die Sprachcodierung im Kapitel 3.3 des Buches „Beispiele von Nachrichtensystemen” stellt eine spezielle Form der Quellencodierung dar.

Systemmodell und Beschreibungsgrößen

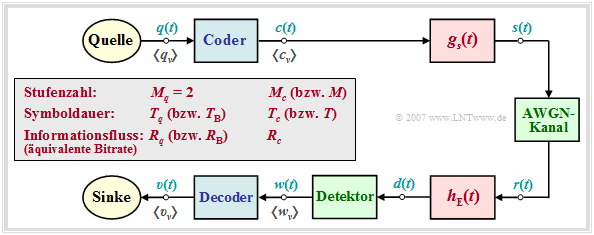

Im weiteren Verlauf des zweiten Kapitels wird von folgendem Blockschaltbild ausgegangen.

Zusätzlich gelten folgende Vereinbarungen:

- Das digitale Quellensignal q(t) sei binär (Mq = 2) und redundanzfrei (Hq = 1 bit/Symbol). Mit der Symboldauer Tq ergibt sich für die Symbolrate der Quelle:

- \[R_q = {H_{q}}/{T_q}= {1}/{T_q}\hspace{1cm}{\rm (Einheit: \hspace{0.15cm}bit/s)}\hspace{0.05cm}.\]

- Wegen Mq = 2 bezeichnen wir im Folgenden Tq auch als die Bitdauer und Rq als die Bitrate. Für den Vergleich von Übertragungssystemen mit unterschiedlicher Codierung werden Tq und Rq (in späteren Kapiteln verwenden wir hierfür TB und RB) stets als konstant angenommen.

- Das Codersignal c(t) und auch das Sendesignal s(t) nach der Impulsformung mit gs(t) besitzen die Stufenzahl Mc, die Symboldauer Tc und die Symbolrate 1/Tc. Die äquivalente Bitrate beträgt

- \[R_c = {{\rm log_2} (M_c)}/{T_c} \hspace{0.05cm}.\]

- Es gilt stets Rc ≥ Rq, wobei das Gleichheitszeichen nur bei den redundanzfreien Codes (rc = 0) gültig ist. Andernfalls erhält man für die relative Coderedundanz:

- \[r_c =({R_c - R_q})/{R_c} = 1 - R_q/{R_c} \hspace{0.05cm}.\]

Hinweis zur Nomenklatur: Die äquivalente Bitrate Rc des Codersignals hat ebenso wie die Bitrate Rq der Quelle die Einheit „bit/s”. Insbesondere in der Literatur zur Kanalcodierung wird dagegen mit Rc häufig die dimensionslose Coderate 1 – rc bezeichnet. Rc = 1 gibt dann einen redundanzfreien Code an, während Rc = 1/3 einen Code mit der Redundanz rc = 2/3 kennzeichnet.

\[R_q = {1}/{T_q}, \hspace{-0.05cm}R_c = {{\rm log_2} (3)} \hspace{-0.05cm}/{T_c} = {3/4 \cdot {\rm log_2} (3)} \hspace{-0.05cm}/{T_q}\hspace{0.1cm}\Rightarrow \hspace{0.1cm}r_c =3/4\cdot {\rm log_2} (3) \hspace{-0.05cm}- \hspace{-0.05cm}1 \approx 15.9\, \% \hspace{0.05cm}.\]

Genauere Informationen zu den 4B3T-Codes finden Sie im Kapitel 2.3.

\(\)

[[File:||class=fit]]