Difference between revisions of "Digital Signal Transmission/Optimal Receiver Strategies"

| Line 1: | Line 1: | ||

{{Header | {{Header | ||

| − | |Untermenü= | + | |Untermenü=Intersymbol Interfering and Equalization Methods |

|Vorherige Seite=Entscheidungsrückkopplung | |Vorherige Seite=Entscheidungsrückkopplung | ||

|Nächste Seite=Viterbi–Empfänger | |Nächste Seite=Viterbi–Empfänger | ||

}} | }} | ||

| − | == | + | == Considered scenario and prerequisites== |

<br> | <br> | ||

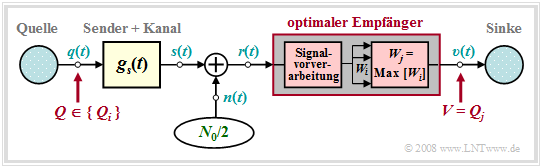

| − | + | All digital receivers described so far always make symbolwise decisions. If, on the other hand, several symbols are decided simultaneously, statistical bindings between the received signal samples can be taken into account during detection, which results in a lower error probability – but at the cost of an additional runtime.<br> | |

| − | In | + | In this – partly also in the next chapter – the following transmission model is assumed:<br> |

| − | [[File:P ID1455 Dig T 3 7 S1 version1.png|center|frame| | + | [[File:P ID1455 Dig T 3 7 S1 version1.png|center|frame|Transmission system with optimal receiver|class=fit]] |

| − | + | Compared to the last two chapters, the following differences arise: | |

| − | *$Q \in \{Q_i\}$ | + | *$Q \in \{Q_i\}$ with $i = 0$, ... , $M-1$ denotes a time-constrained source symbol sequence $\langle q_\nu \rangle$ whose symbols are to be jointly decided by the optimal receiver.<br> |

| − | * | + | *If $Q$ describes a sequence of $N$ redundancy-free binary symbols, set $M = 2^N$. On the other hand, if the decision is symbolwise, $M$ specifies the level number of the digital source.<br> |

| − | * | + | *In the above model, any channel distortions are added to the transmitter and are thus already included in the basic pulse $g_s(t)$ and the signal $s(t)$. This measure is only for a simpler representation and is not a restriction.<br> |

| − | * | + | *Knowing the currently applied received signal $s(t)$, the optimal receiver searches from the set $\{Q_0$, ... , $Q_{M-1}\}$ of the possible source symbol sequences, the receiver searches for the most likely transmitted sequence $Q_j$ and outputs this as a sink symbol sequence $V$. <br> |

| − | * | + | *Before the actual decision algorithm, a numerical value $W_i$ must be derived from the received signal $r(t)$ for each possible sequence $Q_i$ by suitable signal preprocessing. The larger $W_i$ is, the greater the inference probability that $Q_i$ was transmitted.<br> |

| − | * | + | *Signal preprocessing must provide for the necessary noise power limitation and – in the case of strong channel distortions – for sufficient pre-equalization of the resulting intersymbol interferences. In addition, preprocessing also includes sampling for time discretization.<br> |

== MAP and Maximum–Likelihood decision rule== | == MAP and Maximum–Likelihood decision rule== | ||

<br> | <br> | ||

| − | + | The (unconstrained) optimal receiver is called the MAP receiver, where "MAP" stands for "Maximum–a–posteriori".<br> | |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ | + | $\text{Definition:}$ The '''MAP receiver''' determines the $M$ inference probabilities ${\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm}r(t)\big]$ and sets the output sequence $V$ according to the decision rule, where the index is: $i = 0$, ... , $M-1$ as well as $i \ne j$: |

:$${\rm Pr}\big[Q_j \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] > {\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] | :$${\rm Pr}\big[Q_j \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] > {\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] | ||

\hspace{0.05cm}.$$}}<br> | \hspace{0.05cm}.$$}}<br> | ||

| − | + | The [[Theory_of_Stochastic_Signals/Statistical_Dependence_and_Independence#Inference_probability|"inference probability"]] ${\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big]$ indicates the probability with which the sequence $Q_i$ was sent when the received signal $r(t)$ is present at the decision. Using [[Theory_of_Stochastic_Signals/Statistical_Dependence_and_Independence#Conditional_Probability|"Bayes' theorem"]], this probability can be calculated as follows: | |

:$${\rm Pr}\big[Q_i \hspace{0.05cm}|\hspace{0.05cm} r(t)\big] = \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | :$${\rm Pr}\big[Q_i \hspace{0.05cm}|\hspace{0.05cm} r(t)\big] = \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | ||

Q_i \big] \cdot {\rm Pr}\big[Q_i]}{{\rm Pr}[r(t)\big]} | Q_i \big] \cdot {\rm Pr}\big[Q_i]}{{\rm Pr}[r(t)\big]} | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | The MAP decision rule can thus be reformulated or simplified as follows: Let the sink symbol sequence $V = Q_j$ if for all $i \ne j$ holds: | |

:$$\frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | :$$\frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | ||

Q_j \big] \cdot {\rm Pr}\big[Q_j)}{{\rm Pr}\big[r(t)\big]} > \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | Q_j \big] \cdot {\rm Pr}\big[Q_j)}{{\rm Pr}\big[r(t)\big]} > \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} | ||

| Line 49: | Line 49: | ||

Q_i \big] \cdot {\rm Pr}\big[Q_i\big] \hspace{0.05cm}.$$ | Q_i \big] \cdot {\rm Pr}\big[Q_i\big] \hspace{0.05cm}.$$ | ||

| − | + | A further simplification of this MAP decision rule leads to the ML receiver, where "ML" stands for "maximum likelihood".<br> | |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ | + | $\text{Definition:}$ The '''maximum likelihood receiver''' – abbreviated ML – decides according to the conditional forward probabilities ${\rm Pr}\big[r(t)\hspace{0.05cm} \vert \hspace{0.05cm}Q_i \big]$ and sets the output sequence $V = Q_j$ if for all $i \ne j$ holds: |

:$${\rm Pr}\big[ r(t)\hspace{0.05cm} \vert\hspace{0.05cm} | :$${\rm Pr}\big[ r(t)\hspace{0.05cm} \vert\hspace{0.05cm} | ||

Q_j \big] > {\rm Pr}\big[ r(t)\hspace{0.05cm} \vert \hspace{0.05cm} | Q_j \big] > {\rm Pr}\big[ r(t)\hspace{0.05cm} \vert \hspace{0.05cm} | ||

Revision as of 10:56, 30 May 2022

Contents

- 1 Considered scenario and prerequisites

- 2 MAP and Maximum–Likelihood decision rule

- 3 Maximum–Likelihood–Entscheidung bei Gaußscher Störung

- 4 Matched filter receiver vs. correlation receiver

- 5 Darstellung des Korrelationsempfängers im Baumdiagramm

- 6 Korrelationsempfänger bei unipolarer Signalisierung

- 7 Aufgaben zum Kapitel

Considered scenario and prerequisites

All digital receivers described so far always make symbolwise decisions. If, on the other hand, several symbols are decided simultaneously, statistical bindings between the received signal samples can be taken into account during detection, which results in a lower error probability – but at the cost of an additional runtime.

In this – partly also in the next chapter – the following transmission model is assumed:

Compared to the last two chapters, the following differences arise:

- $Q \in \{Q_i\}$ with $i = 0$, ... , $M-1$ denotes a time-constrained source symbol sequence $\langle q_\nu \rangle$ whose symbols are to be jointly decided by the optimal receiver.

- If $Q$ describes a sequence of $N$ redundancy-free binary symbols, set $M = 2^N$. On the other hand, if the decision is symbolwise, $M$ specifies the level number of the digital source.

- In the above model, any channel distortions are added to the transmitter and are thus already included in the basic pulse $g_s(t)$ and the signal $s(t)$. This measure is only for a simpler representation and is not a restriction.

- Knowing the currently applied received signal $s(t)$, the optimal receiver searches from the set $\{Q_0$, ... , $Q_{M-1}\}$ of the possible source symbol sequences, the receiver searches for the most likely transmitted sequence $Q_j$ and outputs this as a sink symbol sequence $V$.

- Before the actual decision algorithm, a numerical value $W_i$ must be derived from the received signal $r(t)$ for each possible sequence $Q_i$ by suitable signal preprocessing. The larger $W_i$ is, the greater the inference probability that $Q_i$ was transmitted.

- Signal preprocessing must provide for the necessary noise power limitation and – in the case of strong channel distortions – for sufficient pre-equalization of the resulting intersymbol interferences. In addition, preprocessing also includes sampling for time discretization.

MAP and Maximum–Likelihood decision rule

The (unconstrained) optimal receiver is called the MAP receiver, where "MAP" stands for "Maximum–a–posteriori".

$\text{Definition:}$ The MAP receiver determines the $M$ inference probabilities ${\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm}r(t)\big]$ and sets the output sequence $V$ according to the decision rule, where the index is: $i = 0$, ... , $M-1$ as well as $i \ne j$:

- $${\rm Pr}\big[Q_j \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] > {\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big] \hspace{0.05cm}.$$

The "inference probability" ${\rm Pr}\big[Q_i \hspace{0.05cm}\vert \hspace{0.05cm} r(t)\big]$ indicates the probability with which the sequence $Q_i$ was sent when the received signal $r(t)$ is present at the decision. Using "Bayes' theorem", this probability can be calculated as follows:

- $${\rm Pr}\big[Q_i \hspace{0.05cm}|\hspace{0.05cm} r(t)\big] = \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} Q_i \big] \cdot {\rm Pr}\big[Q_i]}{{\rm Pr}[r(t)\big]} \hspace{0.05cm}.$$

The MAP decision rule can thus be reformulated or simplified as follows: Let the sink symbol sequence $V = Q_j$ if for all $i \ne j$ holds:

- $$\frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} Q_j \big] \cdot {\rm Pr}\big[Q_j)}{{\rm Pr}\big[r(t)\big]} > \frac{ {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} Q_i\big] \cdot {\rm Pr}\big[Q_i\big]}{{\rm Pr}\big[r(t)\big]}\hspace{0.3cm} \Rightarrow \hspace{0.3cm} {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} Q_j\big] \cdot {\rm Pr}\big[Q_j\big]> {\rm Pr}\big[ r(t)\hspace{0.05cm}|\hspace{0.05cm} Q_i \big] \cdot {\rm Pr}\big[Q_i\big] \hspace{0.05cm}.$$

A further simplification of this MAP decision rule leads to the ML receiver, where "ML" stands for "maximum likelihood".

$\text{Definition:}$ The maximum likelihood receiver – abbreviated ML – decides according to the conditional forward probabilities ${\rm Pr}\big[r(t)\hspace{0.05cm} \vert \hspace{0.05cm}Q_i \big]$ and sets the output sequence $V = Q_j$ if for all $i \ne j$ holds:

- $${\rm Pr}\big[ r(t)\hspace{0.05cm} \vert\hspace{0.05cm} Q_j \big] > {\rm Pr}\big[ r(t)\hspace{0.05cm} \vert \hspace{0.05cm} Q_i\big] \hspace{0.05cm}.$$

Ein Vergleich dieser beiden Definitionen zeigt:

- Bei gleichwahrscheinlichen Quellensymbolen verwenden der ML–Empfänger und der MAP–Empfänger gleiche Entscheidungsregeln; sie sind somit äquivalent.

- Bei nicht gleichwahrscheinlichen Symbolen ist der ML–Empfänger dem MAP–Empfänger unterlegen, da er für die Detektion nicht alle zur Verfügung stehenden Informationen nutzt.

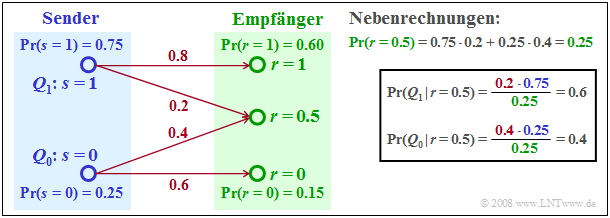

$\text{Beispiel 1:}$ Zur Verdeutlichung von ML– und MAP–Entscheidungsregel konstruieren wir nun ein sehr einfaches Beispiel mit nur zwei Quellensymbolen $(M = 2)$.

- Die beiden möglichen Symbole $Q_0$ und $Q_1$ werden durch die Sendesignale $s = 0$ bzw. $s = 1$ dargestellt.

- Das Empfangssignal kann – warum auch immer – drei verschiedene Werte annehmen, nämlich $r = 0$, $r = 1$ und zusätzlich $r = 0.5$.

Die Empfangswerte $r = 0$ und $r = 1$ werden sowohl vom ML– als auch vom MAP–Entscheider den Senderwerten $s = 0 \ (Q_0)$ bzw. $s = 1 \ (Q_1)$ zugeordnet. Dagegen werden die Entscheider bezüglich des Empfangswertes $r = 0.5$ ein anderes Ergebnis liefern:

- Die Maximum–Likelihood–Entscheidungsregel führt zum Quellensymbol $Q_0$, wegen

- $${\rm Pr}\big [ r= 0.5\hspace{0.05cm}\vert\hspace{0.05cm} Q_0\big ] = 0.4 > {\rm Pr}\big [ r= 0.5\hspace{0.05cm} \vert \hspace{0.05cm} Q_1\big ] = 0.2 \hspace{0.05cm}.$$

- Die MAP–Entscheidung führt dagegen zum Quellensymbol $Q_1$, da entsprechend der Nebenrechnung in der Grafik gilt:

- $${\rm Pr}\big [Q_1 \hspace{0.05cm}\vert\hspace{0.05cm} r= 0.5\big ] = 0.6 > {\rm Pr}\big [Q_0 \hspace{0.05cm}\vert\hspace{0.05cm} r= 0.5\big ] = 0.4 \hspace{0.05cm}.$$

Maximum–Likelihood–Entscheidung bei Gaußscher Störung

Wir setzen nun voraus, dass sich das Empfangssignal $r(t)$ additiv aus einem Nutzsignal $s(t)$ und einem Störanteil $n(t)$ zusammensetzt, wobei die Störung als gaußverteilt und weiß angenommen wird ⇒ AWGN–Rauschen:

- $$r(t) = s(t) + n(t) \hspace{0.05cm}.$$

Eventuelle Kanalverzerrungen werden zur Vereinfachung bereits dem Signal $s(t)$ beaufschlagt.

Die notwendige Rauschleistungsbegrenzung wird durch einen Integrator realisiert; dies entspricht einer Mittelung der Rauschwerte im Zeitbereich. Begrenzt man das Integrationsintervall auf den Bereich $t_1$ bis $t_2$, so kann man für jede Quellensymbolfolge $Q_i$ eine Größe $W_i$ ableiten, die ein Maß für die bedingte Wahrscheinlichkeit ${\rm Pr}\big [ r(t)\hspace{0.05cm} \vert \hspace{0.05cm} Q_i\big ] $ darstellt:

- $$W_i = \int_{t_1}^{t_2} r(t) \cdot s_i(t) \,{\rm d} t - {1}/{2} \cdot \int_{t_1}^{t_2} s_i^2(t) \,{\rm d} t= I_i - {E_i}/{2} \hspace{0.05cm}.$$

Diese Entscheidungsgröße $W_i$ kann über die $k$–dimensioniale Verbundwahrscheinlichkeitsdichte der Störungen $($mit $k \to \infty)$ und einigen Grenzübergängen hergeleitet werden. Das Ergebnis lässt sich wie folgt interpretieren:

- Die Integration dient der Rauschleistungsreduzierung durch Mittelung. Werden vom Maximum–Likelihood–Detektor $N$ Binärsymbole gleichzeitig entschieden, so ist bei verzerrungsfreiem Kanal $t_1 = 0 $ und $t_2 = N \cdot T$ zu setzen.

- Der erste Term der obigen Entscheidungsgröße $W_i$ ist gleich der über das endliche Zeitintervall $NT$ gebildeten Energie–Kreuzkorrelationsfunktion zwischen $r(t)$ und $s_i(t)$ an der Stelle $\tau = 0$:

- $$I_i = \varphi_{r, \hspace{0.08cm}s_i} (\tau = 0) = \int_{0}^{N \cdot T}r(t) \cdot s_i(t) \,{\rm d} t \hspace{0.05cm}.$$

- Der zweite Term gibt die halbe Energie des betrachteten Nutzsignals $s_i(t)$ an, die zu subtrahieren ist. Die Energie ist gleich der AKF des Nutzsignals an der Stelle $\tau = 0$:

- \[E_i = \varphi_{s_i} (\tau = 0) = \int_{0}^{N \cdot T} s_i^2(t) \,{\rm d} t \hspace{0.05cm}.\]

- Bei verzerrendem Kanal ist die Impulsantwort $h_{\rm K}(t)$ nicht diracförmig, sondern beispielsweise auf den Bereich $-T_{\rm K} \le t \le +T_{\rm K}$ ausgedehnt. In diesem Fall muss für die beiden Integrationsgrenzen $t_1 = -T_{\rm K}$ und $t_2 = N \cdot T +T_{\rm K}$ eingesetzt werden.

Matched filter receiver vs. correlation receiver

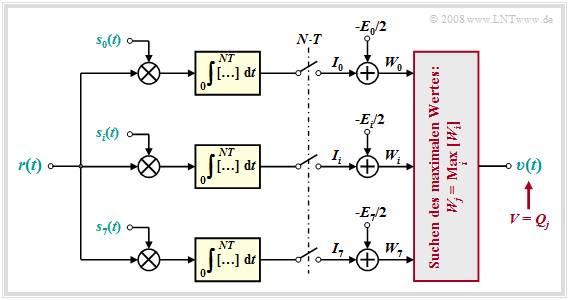

Es gibt verschiedene schaltungstechnische Implementierungen des Maximum–Likelihood–Empfängers.

Beispielsweise können die erforderlichen Integrale durch lineare Filterung und anschließender Abtastung gewonnen werden. Man bezeichnet diese Realisierungsform als Matched–Filter–Empfänger, da hier die Impulsantworten der $M$ parallelen Filter formgleich mit den Nutzsignalen $s_0(t)$, ... , $s_{M-1}(t)$ sind.

- Die $M$ Entscheidungsgrößen $I_i$ sind dann gleich den Faltungsprodukten $r(t) \star s_i(t)$ zum Zeitpunkt $t= 0$.

- Beispielsweise erlaubt der im Kapitel Optimierung der Basisband–Übertragungssysteme ausführlich beschriebene "optimale Binärempfänger" eine Maximum–Likelihood–Entscheidung mit den ML–Parametern $M = 2$ und $N = 1$.

Eine zweite Realisierungsform bietet der Korrelationsempfänger entsprechend der folgenden Grafik.

Man erkennt aus diesem Blockschaltbild für die angegebenen Parameter:

- Der gezeichnete Korrelationsempfänger bildet insgesamt $M = 8$ Kreuzkorrelationsfunktionen zwischen dem Empfangssignal $r(t) = s_k(t) + n(t)$ und den möglichen Sendesignalen $s_i(t), \ i = 0$, ... , $M-1$. Vorausgesetzt ist für die folgende Beschreibung, dass das Nutzsignal $s_k(t)$ gesendet wurde.

- Der Korrelationsempfänger sucht nun den maximalen Wert $W_j$ aller Korrelationswerte und gibt die dazugehörige Folge $Q_j$ als Sinkensymbolfolge $V$ aus. Formal lässt sich die ML–Entscheidungsregel wie folgt ausdrücken:

- $$V = Q_j, \hspace{0.2cm}{\rm falls}\hspace{0.2cm} W_i < W_j \hspace{0.2cm}{\rm f\ddot{u}r}\hspace{0.2cm} {\rm alle}\hspace{0.2cm} i \ne j \hspace{0.05cm}.$$

- Setzt man weiter voraus, dass alle Sendesignale $s_i(t)$ die genau gleiche Energie besitzen, so kann man auf die Subtraktion von $E_i/2$ in allen Zweigen verzichten. In diesem Fall werden folgende Korrelationswerte miteinander verglichen $(i = 0$, ... , $M-1)$:

- \[I_i = \int_{0}^{NT} s_j(t) \cdot s_i(t) \,{\rm d} t + \int_{0}^{NT} n(t) \cdot s_i(t) \,{\rm d} t \hspace{0.05cm}.\]

- Mit großer Wahrscheinlichkeit ist $I_j = I_k$ größer als alle anderen Vergleichswerte $I_{j \ne k}$. Ist das Rauschen $n(t)$ allerdings zu groß, so wird auch der Korrelationsempfänger eine Fehlentscheidung treffen.

Darstellung des Korrelationsempfängers im Baumdiagramm

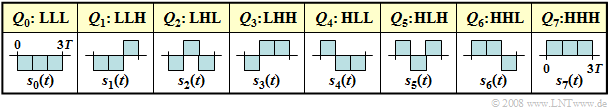

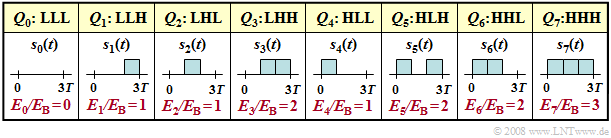

Verdeutlichen wir uns die Funktionsweise des Korrelationsempfängers im Baumdiagramm, wobei die $2^3 = 8$ möglichen Quellensymbolfolgen $Q_i$ der Länge $N = 3$ durch bipolare rechteckförmige Sendesignale $s_i(t)$ repräsentiert werden:

Die möglichen Symbolfolgen $Q_0 = \rm LLL$, ... , $Q_7 = \rm HHH$ und die zugehörigen Sendesignale $s_0(t)$, ... , $s_7(t)$ sind oben aufgeführt.

- Aufgrund der bipolaren Amplitudenkoeffizienten und der Rechteckform sind alle Signalenergien gleich: $E_0 = \text{...} = E_7 = N \cdot E_{\rm B}$, wobei $E_{\rm B}$ die Energie eines Einzelimpulses der Dauer $T$ angibt.

- Deshalb kann auf die Subtraktion des Terms $E_i/2$ in allen Zweigen verzichtet werden ⇒ eine auf den Korrelationswerten $I_i$ basierende Entscheidung liefert ebenso zuverlässige Ergebnisse wie die Maximierung der korrigierten Werte $W_i$.

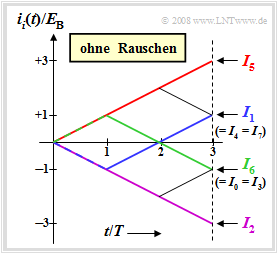

$\text{Beispiel 2:}$ In der Grafik sind die fortlaufenden Integralwerte dargestellt, wobei vom tatsächlich gesendeten Signal $s_5(t)$ und dem rauschfreien Fall ausgegangen wird. Für diesen Fall gilt für die zeitabhängigen Integralwerte und die Integralendwerte:

- $$i_i(t) = \int_{0}^{t} r(\tau) \cdot s_i(\tau) \,{\rm d} \tau = \int_{0}^{t} s_5(\tau) \cdot s_i(\tau) \,{\rm d} \tau \hspace{0.3cm} \Rightarrow \hspace{0.3cm}I_i = i_i(3T). $$

Die Grafik kann wie folgt interpretiert werden::

- Wegen der Rechteckform der Signale $s_i(t)$ sind alle Funktionsverläufe $i_i(t)$ geradlinig. Die auf $E_{\rm B}$ normierten Endwerte sind $+3$, $+1$, $-1$ und $-3$.

- Der maximale Endwert ist $I_5 = 3 \cdot E_{\rm B}$ (roter Kurvenverlauf), da tatsächlich das Signal $s_5(t)$ gesendet wurde. Ohne Rauschen trifft der Korrelationsempfänger somit natürlich immer die richtige Entscheidung.

- Der blaue Kurvenzug $i_1(t)$ führt zum Endwert $I_1 = -E_{\rm B} + E_{\rm B}+ E_{\rm B} = E_{\rm B}$, da sich $s_1(t)$ von $s_5(t)$ nur im ersten Bit unterscheidet. Die Vergleichswerte $I_4$ und $I_7$ sind ebenfalls gleich $E_{\rm B}$.

- Da sich $s_0(t)$, $s_3(t)$ und $s_6(t)$ vom gesendeten $s_5(t)$ in zwei Bit unterscheiden, gilt $I_0 = I_3 = I_6 =-E_{\rm B}$. Die grüne Kurve zeigt $s_6(t)$, das zunächst ansteigt (erstes Bit stimmt überein) und dann über zwei Bit abfällt.

- Die violette Kurve führt zum Endwert $I_2 = -3 \cdot E_{\rm B}$. Das zugehörige Signal $s_2(t)$ unterscheidet sich von $s_5(t)$ in allen drei Symbolen und es gilt $s_2(t) = -s_5(t)$.

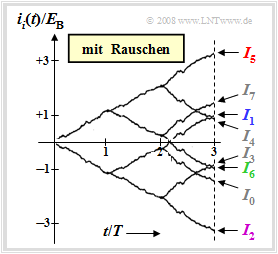

$\text{Beispiel 3:}$ Die Grafik zu diesem Beispiel beschreibt den gleichen Sachverhalt wie das $\text{Beispiel 2}$, doch es wird nun vom Empfangssignal $r(t) = s_5(t)+ n(t)$ ausgegangen. Die Varianz des AWGN–Rauschens $n(t)$ beträgt hierbei $\sigma_n^2 = 4 \cdot E_{\rm B}/T$.

Man erkennt aus dieser Grafik im Vergleich zum rauschfreien Fall:

- Die Funktionsverläufe sind aufgrund des Rauschanteils $n(t)$ nun nicht mehr gerade und es ergeben sich auch etwas andere Endwerte als ohne Rauschen.

- Im betrachteten Beispiel entscheidet der Korrelationsempfänger aber mit großer Wahrscheinlichkeit richtig, da die Differenz zwischen $I_5$ und dem zweitgrößeren Wert $I_7$ mit $1.65\cdot E_{\rm B}$ verhältnismäßig groß ist.

- Die Fehlerwahrscheinlichkeit ist im hier betrachteten Beispiel allerdings nicht besser als die des Matched–Filter–Empfängers mit symbolweiser Entscheidung.

- Entsprechend dem Kapitel Optimierung der Basisband–Übertragungssysteme gilt auch hier:

- $$p_{\rm S} = {\rm Q} \left( \sqrt{ {2 \cdot E_{\rm B} }/{N_0} }\right) = {1}/{2} \cdot {\rm erfc} \left( \sqrt{ { E_{\rm B} }/{N_0} }\right) \hspace{0.05cm}.$$

$\text{Fazit:}$

- Weist das Eingangssignal keine statistischen Bindungen auf wie im $\text{Beispiel 2}$, so ist durch die gemeinsame Entscheidung von $N$ Symbolen gegenüber der symbolweisen Entscheidung keine Verbesserung zu erzielen.

- Bei Vorhandensein von statistischen Bindungen wird durch die gemeinsame Entscheidung von $N$ Symbolen die Fehlerwahrscheinlichkeit gegenüber $p_{\rm S} = {\rm Q} \left( \sqrt{ {2 \cdot E_{\rm B} }/{N_0} }\right)$ (gültig für symbolweise Entscheidung) merklich verringert, da der Maximum–Likelihood–Empfänger die Bindungen berücksichtigt.

- Solche Bindungen können entweder durch sendeseitige Codierung bewusst erzeugt werden (siehe $\rm LNTwww$-Buch Channel Coding) oder durch (lineare) Kanalverzerrungen ungewollt entstehen.

- Bei Vorhandensein solcher Impulsinterferenzen ist die Berechnung der Fehlerwahrscheinlichkeit deutlich schwieriger. Es können jedoch vergleichbare Näherungen wie beim Viterbi–Empfänger angegeben werden, die am Ende des nächsten Kapitels angegeben sind.

Korrelationsempfänger bei unipolarer Signalisierung

Bisher sind wir bei der Beschreibung des Korrelationsempfänger stets von binärer bipolarer Signalisierung ausgegangen:

- $$a_\nu = \left\{ \begin{array}{c} +1 \\ -1 \\ \end{array} \right.\quad \begin{array}{*{1}c} {\rm{f\ddot{u}r}} \\ {\rm{f\ddot{u}r}} \\ \end{array}\begin{array}{*{20}c} q_\nu = \mathbf{H} \hspace{0.05cm}, \\ q_\nu = \mathbf{L} \hspace{0.05cm}. \\ \end{array}$$

Nun betrachten wir den Fall der binären unipolaren Digitalsignalübertragung gilt:

- $$a_\nu = \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right.\quad \begin{array}{*{1}c} {\rm{f\ddot{u}r}} \\ {\rm{f\ddot{u}r}} \\ \end{array}\begin{array}{*{20}c} q_\nu = \mathbf{H} \hspace{0.05cm}, \\ q_\nu = \mathbf{L} \hspace{0.05cm}. \\ \end{array}$$

Die $2^3 = 8$ möglichen Quellensymbolfolgen $Q_i$ der Länge $N = 3$ werden nun durch unipolare rechteckförmige Sendesignale $s_i(t)$ repräsentiert. Nachfolgend aufgeführt sind die Symbolfolgen $Q_0 = \rm LLL$, ... , $Q_7 = \rm HHH$ und die Sendesignale $s_0(t)$, ... , $s_7(t)$.

Durch Vergleich mit der entsprechenden Tabelle für bipolare Signalisierung erkennt man:

- Aufgrund der unipolaren Amplitudenkoeffizienten sind nun die Signalenergien $E_i$ unterschiedlich, zum Beispiel gilt $E_0 = 0$ und $E_7 = 3 \cdot E_{\rm B}$.

- Hier führt die auf den Integralendwerten $I_i$ basierende Entscheidung nicht zum richtigen Ergebnis.

- Vielmehr muss nun auf die korrigierten Vergleichswerte $W_i = I_i- E_i/2$ zurückgegriffen werden.

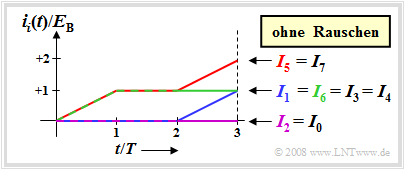

$\text{Beispiel 4:}$ In der Grafik sind die fortlaufenden Integralwerte dargestellt, wobei wieder vom tatsächlich gesendeten Signal $s_5(t)$ und dem rauschfreien Fall ausgegangen wird. Das entsprechende bipolare Äquivalent wurde im Beispiel 2 betrachtet.

Für dieses Beispiel ergeben sich folgende Vergleichswerte, jeweils normiert auf $E_{\rm B}$:

- $$I_5 = I_7 = 2, \hspace{0.2cm}I_1 = I_3 = I_4= I_6 = 1 \hspace{0.2cm}, \hspace{0.2cm}I_0 = I_2 = 0 \hspace{0.05cm},$$

- $$W_5 = 1, \hspace{0.2cm}W_1 = W_4 = W_7 = 0.5, \hspace{0.2cm} W_0 = W_3 =W_6 =0, \hspace{0.2cm}W_2 = -0.5 \hspace{0.05cm}.$$

Das bedeutet:

- Bei einem Vergleich hinsichtlich der maximalen $I_i$–Werte wären die Quellensymbolfolgen $Q_5$ und $Q_7$ gleichwertig.

- Berücksichtigt man die unterschiedlichen Energien $(E_5 = 2, \ E_7 = 3)$, so wird dagegen wegen $W_5 > W_7$ eindeutig für die Folge $Q_5$ entschieden.

- Der Korrelationsempfänger gemäß $W_i = I_i- E_i/2$ entscheidet also auch bei unipolarer Signalisierung richtig auf $s(t) = s_5(t)$.

Aufgaben zum Kapitel

Aufgabe 3.9: Korrelationsempfänger für unipolare Signalisierung

Aufgabe 3.10: Baumdiagramm bei Maximum-Likelihood